Gmail, Microsoft, Meta, LinkedIn : Ils scannent déjà vos messages - volontairement !

Le contrôle volontaire des conversations est déjà en place depuis 2021, sous le nom de Règlement (UE) 2021/1232. À l'instar des obligations de numérisation en vigueur au Royaume-Uni et aux États-Unis, ce règlement permet aux grandes entreprises technologiques de numériser toutes vos données. Mais qu'est-ce que les services analysent en vertu de ce règlement, analysent-ils également les anciens messages et qu'est-ce que cela signifie pour la protection des données et de la vie privée ? Une plongée en profondeur.

Et si vous pensez que cela ne vous concerne pas parce que vous n’avez rien à cacher, lisez l’histoire de ce père qui a vu tout son compte Google supprimé parce qu’il avait envoyé une photo de son fils nu à leur médecin de famille.

Maintenant que j’ai attiré votre attention, vérifiez qui scanne vos courriels et vos messages et ce que vous pouvez faire pour y remédier !

Contrôle volontaire du chat : Règlement (UE) 2021/1232

Depuis plus de trois ans, l’Union européenne discute d’un règlement visant à détecter le matériel pédopornographique (CSAM), appelé “Chat Control” en raison de ses immenses implications en matière de surveillance. Alors que les défenseurs de la vie privée ont réussi à supprimer l’obligation de briser le chiffrement de bout en bout dans la proposition actuelle de contrôle des conversations, l’UE a déjà mis en place une forme volontaire de contrôle des conversations qui est largement utilisée par les services Big Tech américains : le règlement 2021/1232.

Gmail, Facebook, Instagram, WhatsApp, Microsoft, LinkedIn, Apple - tous analysent vos données sur la base de ce règlement, souvent à l’aide d’un outil développé par Microsoft, appelé photoDNA. Big Tech n’analyse que les messages et les courriels nouvellement reçus, et non les anciens messages, qui ont déjà été analysés par le passé.

La Commission européenne a demandé à Big Tech de lui fournir des données sur ces analyses afin de prouver qu’elles étaient proportionnées. Mais la Commission européenne n’a pas été en mesure de prouver ce qu’elle avançait :

En ce qui concerne la proportionnalité du règlement (UE) 2021/1232, la question est de savoir si le règlement atteint l’équilibre recherché entre, d’une part, la réalisation de l’objectif d’intérêt général consistant à lutter efficacement contre les crimes extrêmement graves en cause et, d’autre part, la nécessité de protéger les droits fondamentaux des enfants (par exemple, la dignité, l’intégrité, l’interdiction de la pornographie enfantine).) et, d’autre part, la sauvegarde des droits fondamentaux des utilisateurs des services couverts (par exemple, la vie privée, la protection des données à caractère personnel, la liberté d’expression, le droit à un recours effectif, etc.) Les données disponibles sont insuffisantes pour apporter une réponse définitive à cette question”.

Au lieu de prouver que le règlement est proportionné - car le balayage de masse des données personnelles est une intrusion grave dans la vie privée de chaque citoyen et ne doit pas être autorisé “au cas où” - la Commission européenne déclare simplement que le balayage des messages n’est pas disproportionné et qu’il est donc autorisé :

Il n’est pas possible et il ne serait pas approprié d’appliquer une norme numérique pour évaluer la proportionnalité en termes de nombre d’enfants sauvés, étant donné l’impact négatif significatif sur la vie et les droits d’un enfant causé par les abus sexuels. Néanmoins, à la lumière de ce qui précède, rien n’indique que la dérogation n’est pas proportionnée”.

Ce renversement de la charge de la preuve a été fortement critiqué par Netzpolitik ainsi que par Patrick Breyer, ancien parlementaire européen et avocat, qui qualifie la conclusion de la Commission européenne d‘“absurdité juridique”.

Mais regardons les données nous-mêmes !

Les Big Tech analysent des milliards de données

Seuls deux fournisseurs de services ont communiqué à la Commission européenne des chiffres concrets sur l’ampleur de l’analyse volontaire du CSAM : Microsoft et LinkedIn.

-

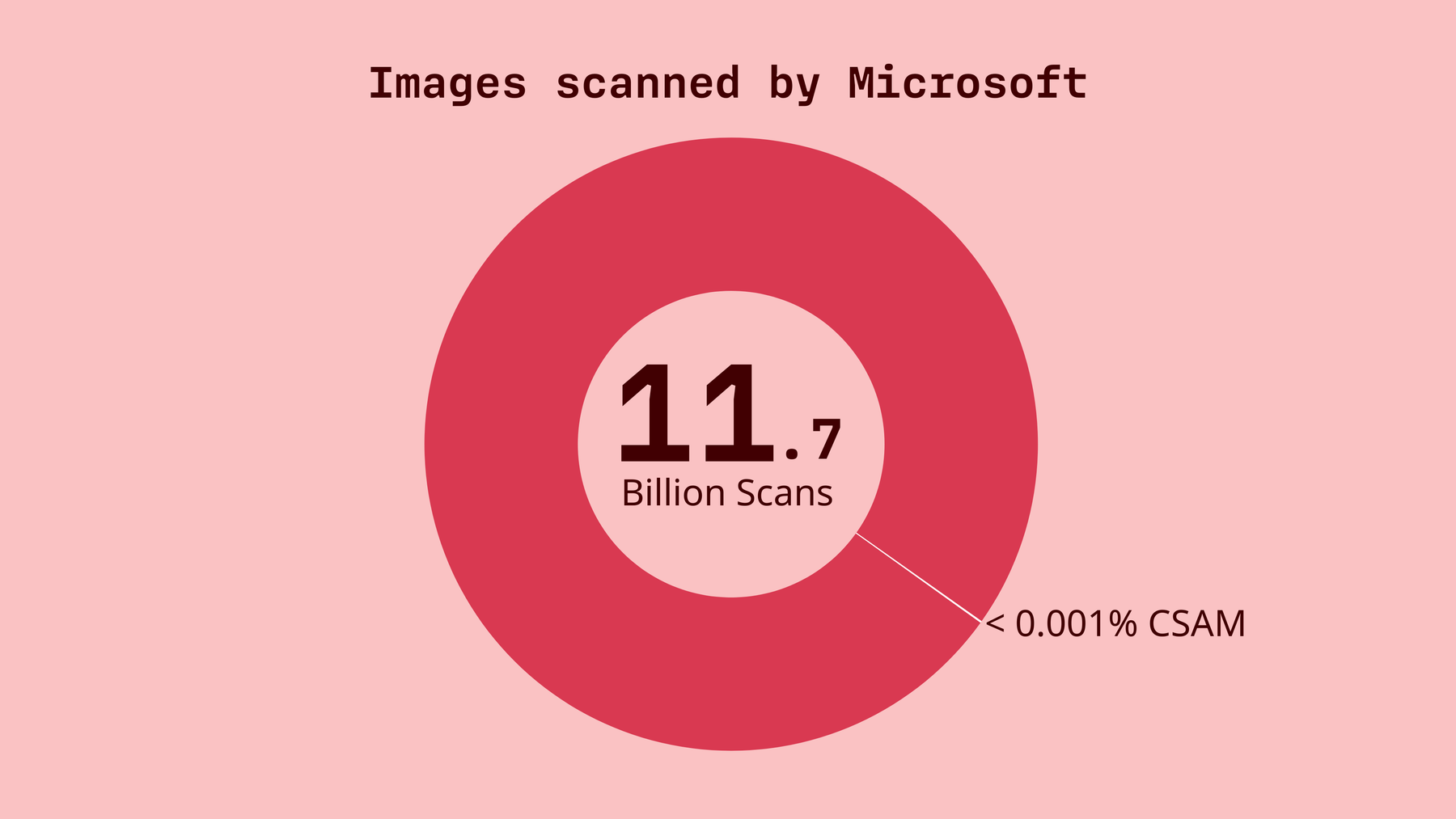

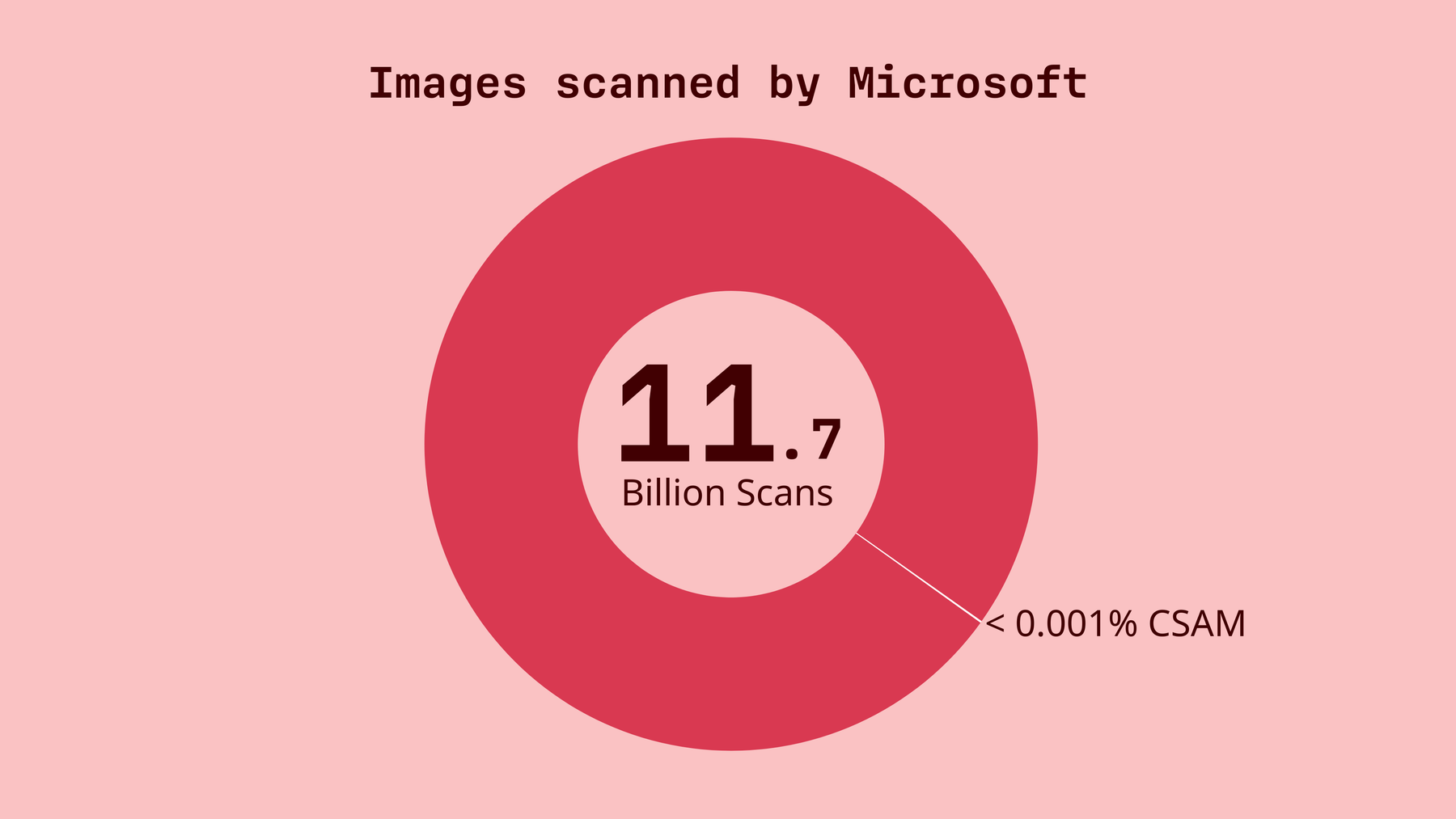

Microsoft a scanné plus de 11,7 milliards d’images et de vidéos dans le monde en 2023 et un peu moins de 10 milliards en 2024. L’entreprise n’a pas fourni de chiffres pour l’UE uniquement.

-

En 2023, Microsoft a signalé 32 000 ensembles de données comme pouvant contenir des informations relatives à des abus sexuels sur des enfants, dont plus de 9 000 ensembles de données dans l’UE. Cela représente 0,0002735 %, soit 1 résultat positif pour 365 000 analyses.

-

En 2024, Microsoft a signalé 26 000 ensembles de données comme étant susceptibles de contenir des données relatives à des abus sexuels sur des enfants, dont plus de 5 800 ensembles de données dans l’UE. Cela représente 0,00027083 %, soit 1 résultat positif pour 369 000 analyses.

-

Les volumes de LinkedInétaient bien moindres, mais toutes les analyses concernaient des contenus européens.

-

En 2023, plus de 24 millions d’images et plus d’un million de vidéos ont été analysées, ce qui a entraîné le signalement de deux images et d’aucune vidéo en tant que matériel susceptible d’être utilisé pour des abus sexuels sur des enfants. Cela représente 0,00000833 %, soit 1 résultat positif pour 12 millions d’analyses.

-

En 2024, plus de 22 millions d’images et plus de 2 millions de vidéos ont été analysées, et 1 image et aucune vidéo n’ont été signalées comme pouvant contenir du matériel pédopornographique. Cela représente 0,00000417 %, soit 1 résultat positif pour 24 millions d’analyses.

Dans les deux cas, le balayage de masse n’a produit que des résultats minimes, mais la Commission européenne estime que la mesure de contrôle volontaire du chat est proportionnée.

Google n’a pas divulgué le nombre de contenus scannés, mais seulement les résultats, mais compte tenu du fait que Google est l’un des plus grands services en ligne, il est fort probable que les chiffres se comptent en millions. En 2023 et 2024, Google a signalé respectivement 1 558 et 1 824 ensembles de données. Compte tenu de la taille de Google, les volumes d’analyse sont probablement comparables à ceux de Microsoft, ce qui signifie que les résultats restent également bien en deçà de la fourchette par mille.

La méta avec des services tels que Facebook, Instagram et WhatsApp se démarque nettement avec des chiffres beaucoup plus élevés. En 2023 et 2024, le géant technologique de la Silicon Valley a signalé 3,6 millions et 1,5 million d’images et de vidéos comme étant des CSAM potentiels dans l’UE.

Une tendance similaire apparaît lorsqu’on examine les rapports des utilisateurs : Chez Google, 297 (2023) et 216 (2024) utilisateurs ont signalé des contenus illégaux. Sur Meta, 254 500 (2023) et 76 900 (2024) utilisateurs ont signalé des contenus illégaux. Le rapport de la Commission n’explique pas pourquoi ces chiffres diffèrent si massivement.

Ces chiffres, lorsqu’on les examine d’un œil critique, ne prouvent pas du tout que le balayage massif des messages de tout un chacun est proportionné. Et le projet de contrôle du chat, qui sera bientôt discuté dans le cadre du Trilogue, pourrait permettre un balayage encore plus important - toujours sur une base volontaire, mais avec des conséquences significatives pour votre vie privée.

Le bon et le mauvais côté des choses

L’aspect positif de la proposition actuelle sur le contrôle des conversations est que le balayage des courriels et des messages de conversation restera volontaire. La proposition n’obligera pas les fournisseurs de messagerie électronique cryptée de bout en bout, comme Tuta Mail, à mettre en place une porte dérobée pour le cryptage. Chez Tuta, vos données resteront donc en sécurité. Chez Tuta, nous sommes là pour défendre votre droit à la vie privée ; lorsque le débat sur le contrôle du chat était à son apogée en 2024, nous avons même menacé de poursuivre l’UE pour avoir négligé le droit de chacun à la vie privée, ce qui n’est plus nécessaire aujourd’hui.

Cependant, le contrôle volontaire du chat n’est pas seulement fondamentalement mauvais, il est erroné : Sans prouver que la mesure est proportionnée à la protection des enfants, la Commission européenne sacrifie la vie personnelle de chacun en ouvrant la voie à une immense intrusion de Big Tech dans la vie privée de tous - et Big Tech n’a pas besoin de se faire prier deux fois.

Ainsi, Gmail, Microsoft, LinkedIn, Meta - tous scannent joyeusement vos données, sans que cela ne leur pose le moindre problème. Cela leur permet non seulement de scanner vos données à la recherche de CSAM, mais aussi de tout ce qu’ils veulent, de vous connaître à fond comme l’a dit un jour un PDG de Google, et de créer un profil à votre sujet pour afficher des publicités ciblées.

Passer au respect de la vie privée

Pourtant, vous avez le choix : il existe des services qui proposent des solutions gratuites et sécurisées de messagerie électronique, de chat et de médias sociaux, sans aucun suivi ni profilage.

Dites “non” aux grandes entreprises technologiques et à leur collecte de données. Dites “Bonjour” à la vie privée !