Microsoft Copilot avait accès aux courriels confidentiels des organisations - sans autorisation.

Microsoft a reconnu qu'un bogue dans Microsoft 365 Copilot a permis à l'assistant d'intelligence artificielle d'accéder par inadvertance à des courriels confidentiels.

Selon Bleeping Computer, un rapport de service concernant le bogue(répertorié sous le numéro CW1226324), initialement détecté le 21 janvier, affecte la fonction de chat de l’onglet “travail” de Copilot. Cette fonction lui permet de lire et de résumer les courriels contenus dans les dossiers envoyés et brouillons des utilisateurs. Plus inquiétant encore, l’IA avait accès à la lecture et au résumé des courriels marqués par des étiquettes de confidentialité, qui sont explicitement conçues pour garantir que les outils automatisés n’y ont pas accès.

C’est ce qu’a déclaré Microsoft lorsqu’elle a confirmé le problème à Bleeping Computer :

Le Chat de l’onglet de travail de Microsoft 365 Copilot résume les messages électroniques même si ces messages ont une étiquette de sensibilité appliquée et qu’une politique DLP est configurée”.

Le géant technologique de la Silicon Valley a également déclaré qu’un “problème de code permet aux éléments des dossiers Envoyés et Brouillons d’être pris en charge par Copilot même si des étiquettes confidentielles sont en place” Microsoft a maintenant confirmé qu’il a commencé à déployer un correctif pour le bogue au début du mois de février. Mercredi, Microsoft a déclaré qu’elle surveillait le déploiement et qu’elle contactait certains utilisateurs pour confirmer que le correctif fonctionnait.

L’utilisation de Copilot pour augmenter la productivité ne vaut pas le risque

Microsoft a poussé le déploiement de son IA, Copilot, dans toutes les applications de Microsoft 365 - non seulement pour un usage personnel, mais aussi pour que les entreprises l’intègrent dans leurs effectifs. En septembre 2025, Copilot Chat, le chat de Microsoft alimenté par l’IA qui permet aux utilisateurs d’interagir avec des agents d’IA, a été déployé dans Excel, Word, Outlook, PowerPoint et OneNote pour les clients professionnels de Microsoft 365. Quatre mois plus tard, un bogue a compromis les données sensibles des utilisateurs de Microsoft 365.

Alors que l’utilisation d’assistants d’intelligence artificielle, comme Copilot Chat, est globalement présentée par les géants de la technologie comme un moyen de stimuler la productivité et d’accélérer les flux de travail, il est clair que les technologies d’intelligence artificielle nouvelles et en développement peuvent représenter un risque extrême pour la sécurité et la vie privée, en particulier pour les organisations qui doivent protéger des informations sensibles.

Hausse des prix, IA et un mauvais bug : Adieu la confidentialité des courriels !

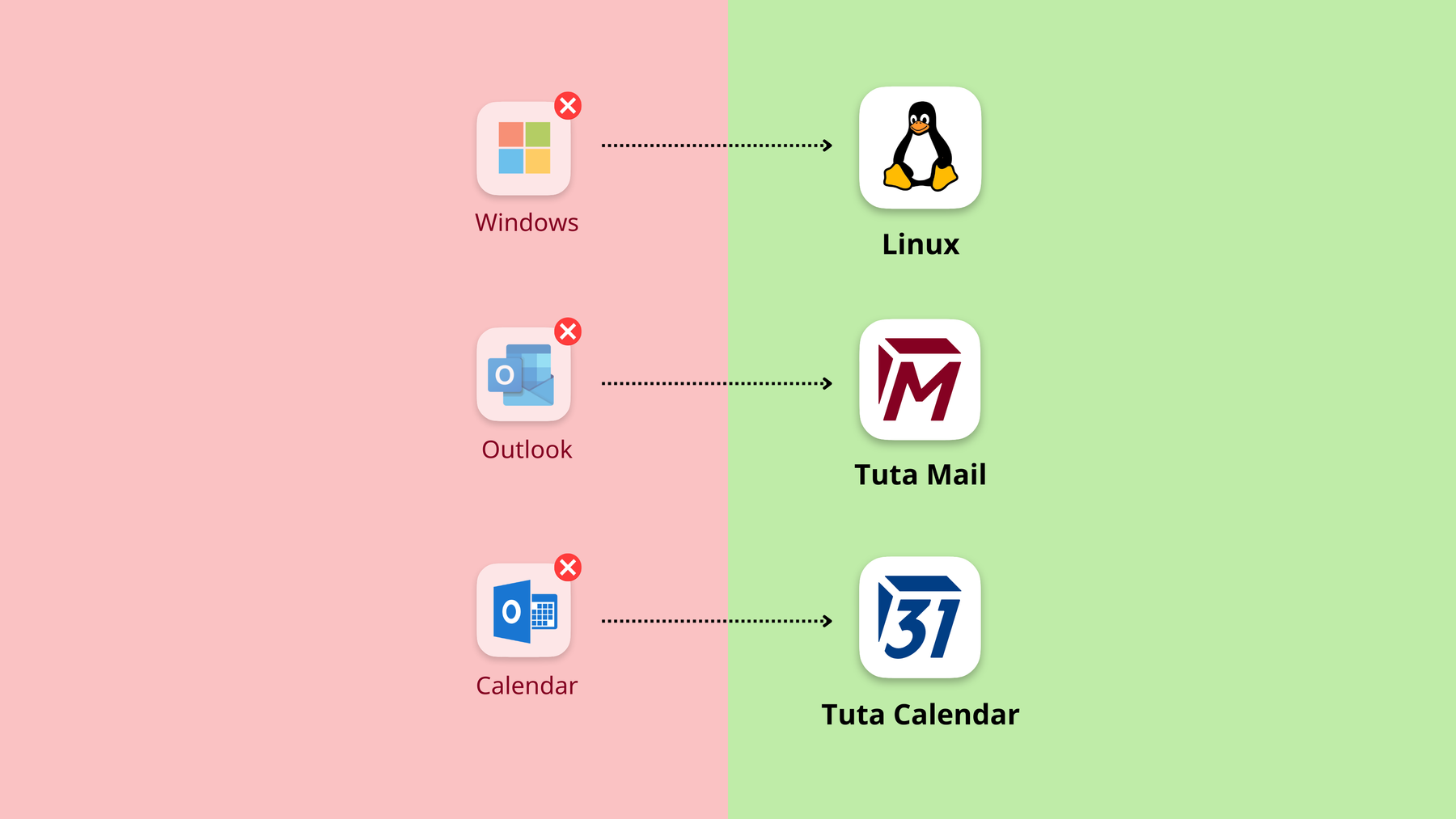

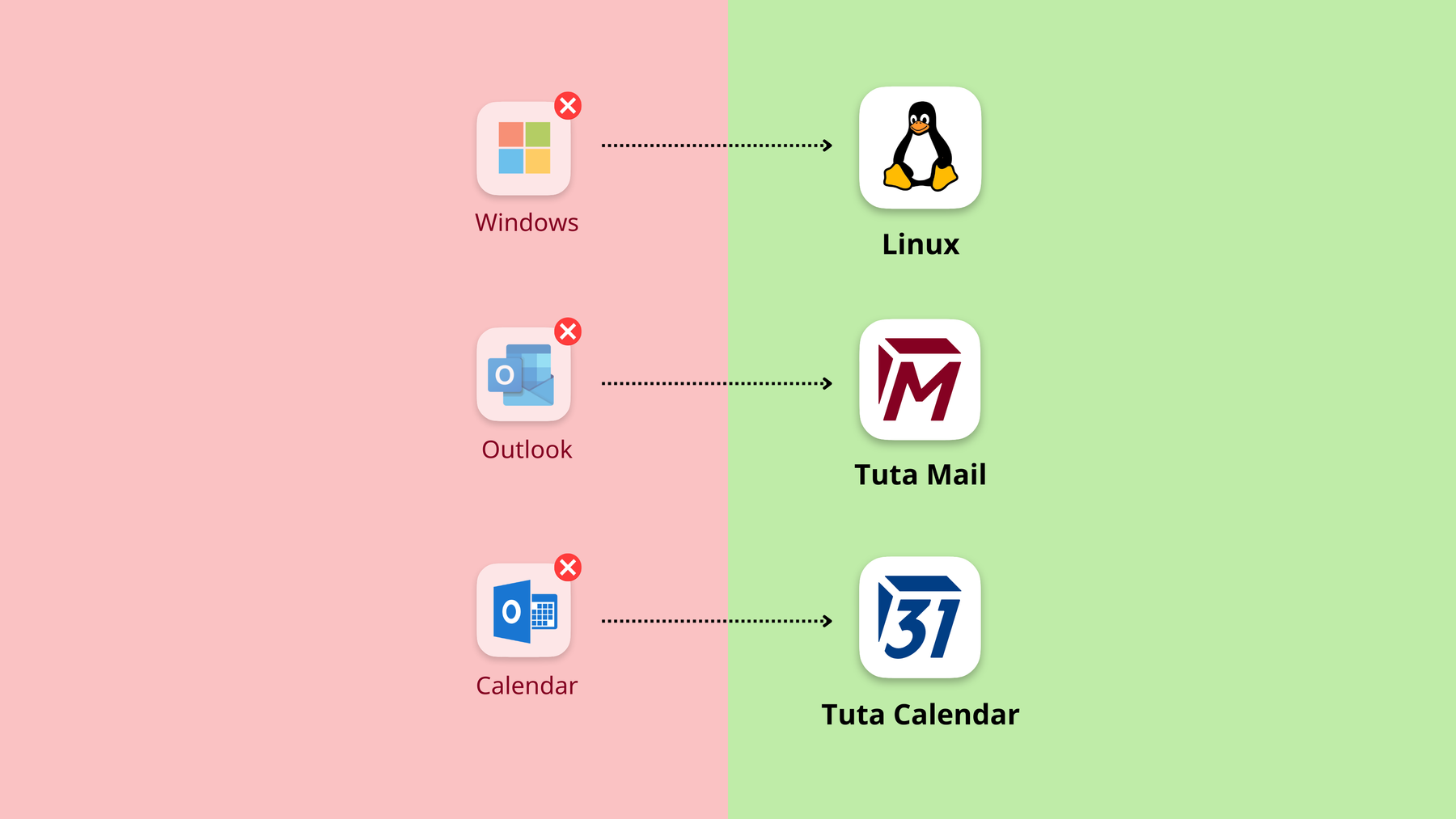

De nombreuses entreprises utilisent aujourd’hui Microsoft Outlook, principalement parce qu’il est fourni avec les outils Office de Microsoft, tels que Word et Excel, mais les évolutions récentes montrent qu’il devient de plus en plus intéressant de passer à d’autres solutions, en particulier pour la messagerie électronique.

-

En janvier 2026, un bogue a permis à Copilot Chat de résumer des courriels malgré la configuration d’étiquettes de sensibilité et de politiques DLP.

-

En 2025, Microsoft a annoncé de fortes hausses de prix pour Microsoft 365 à partir de juillet 2026.

-

En septembre 2025, Microsoft a déployé Copilot Chat dans Excel, Word, Outlook, PowerPoint et OneNote pour les clients professionnels payants de Microsoft 365.

Une chose ressort clairement de tout cela : Si votre entreprise utilise Microsoft 365, il est temps d’abandonner le verrouillage du fournisseur et de protéger vos informations confidentielles. Heureusement, il existe d’excellentes alternatives aux produits Microsoft.

Il est temps d’abandonner le verrouillage des fournisseurs

Ce n’est ni le premier ni le dernier problème de sécurité auquel Microsoft est confronté.

-

En 2024, le gouvernement américain a demandé à Microsoft de corriger sa sécurité avant d’ajouter de nouvelles fonctionnalités après que la Chine a piraté les serveurs de messagerie de Microsoft.

-

En 2025, les entreprises ont été averties de ne pas adopter le “Nouvel Outlook”, car il ne respecte pas les lois sur la protection des données auxquelles les entreprises doivent se conformer.

-

En 2025, Microsoft a déclenché la tendance à la souveraineté numérique européenne, après que l’avocat de Microsoft en France a confirmé que toutes les données hébergées chez Microsoft, même si elles sont stockées dans des centres de données européens, peuvent être consultées par le gouvernement américain - sans avertissement.

Avec l’intégration et le développement rapide de Copilot dans Microsoft 365, les données des individus et des organisations resteront en danger.

L’annonce de ce bogue, quelques mois seulement après le déploiement de Copilot dans les plans d’affaires de Microsoft 365, souligne pourquoi les assistants d’intelligence artificielle n’ont pas leur place dans les courriels et l’importance d’utiliser des courriels chiffrés de bout en bout, comme Tuta Mail.