Scanning CSAM : Les mensonges de la Commission européenne dévoilés - La surveillance ne sauvera pas les enfants.

Nous avons analysé les ordres de surveillance des télécommunications. Les données montrent que le balayage CSAM de l'UE est totalement disproportionné et doit être arrêté.

Dans son projet de loi visant à lutter contre les abus sexuels sur les enfants, la Commission européenne décrit l’un des appareils de surveillance de masse les plus sophistiqués jamais déployés en dehors de la Chine : le balayage CSAM sur les appareils de tout le monde. En tant que service de messagerie, nous recevons régulièrement des ordres de surveillance de la part des autorités allemandes. Nous avons analysé ces données pour savoir si les ordres de surveillance sont émis pour poursuivre les agresseurs d’enfants.

Le balayage CSAM

Le projet de règlement de la Commission européenne sur la prévention et la lutte contre les abus envers les enfants est une attaque frontale contre les droits civils. Et la Commission européenne fait pression pour que ce projet devienne une loi avec des exagérations massives.

En tant que citoyens, nous sommes en droit d’attendre davantage de la Commission européenne. Le moins que nous puissions demander, lorsque la Commission veut introduire des mécanismes de surveillance qui affaibliront considérablement la cybersécurité de l’Europe, c’est une communication honnête.

Personne ne nie que les abus sexuels sur les enfants sont un problème important qui doit être traité. Mais lorsqu’on propose des mesures aussi radicales que l’analyse par le CSAM de chaque message de discussion privé, les arguments doivent être solides. Sinon, la Commission européenne n’aide personne, ni les enfants, ni nos sociétés libres et démocratiques.

La Commission européenne a réussi à introduire trois arguments dans le débat public afin de faire basculer l’opinion publique en faveur du balayage de tous les appareils à la recherche de matériel de CSA. Mais ces arguments sont manifestement faux :

- Un sur cinq : La Commission européenne affirme qu’un enfant sur cinq dans l’UE serait victime d’abus sexuels.

- La surveillance basée sur l’IA ne nuirait pas à notre droit à la vie privée, mais sauverait les enfants.

- 90 % du CSAM serait hébergé sur des serveurs européens

La Commission européenne utilise l’affirmation “un sur cinq” pour justifier la proposition de surveillance générale de masse de tous les citoyens européens.

Oui, la maltraitance des enfants est un problème immense. Tous les experts en matière de protection de l’enfance s’accordent à dire que la politique doit faire davantage pour protéger les plus vulnérables de notre société : les enfants.

Néanmoins, la question de la proportion doit être examinée de très près lorsqu’il s’agit de scanner le CSAM sur nos appareils personnels : Est-il normal que l’UE introduise des mécanismes de surveillance de masse pour tous les citoyens de l’UE dans le but de lutter contre les abus sexuels sur les enfants ?

L’association allemande “Digitale Gesellschaft” a publié une vidéo qui vise à répondre également à la question de la proportionnalité ; elle vaut la peine d’être regardée !

Pour trouver une réponse à la question de la proportionnalité, nous devons faire abstraction de la propagande de la Commission européenne et poser plusieurs questions :

1. Un sur cinq

D’où vient le chiffre “un sur cinq” ?

Aucune statistique ne vient étayer l’affirmation “un sur cinq”. Ce chiffre est mis en évidence sur un site web du Conseil de l’Europe, mais sans en donner la source.

Selon l’Organisation mondiale de la santé (OMS), 9,6 % des enfants dans le monde sont victimes d’abus sexuels. Contrairement aux chiffres de l’UE, ces données sont basées sur une étude, une analyse d’enquêtes communautaires.

Néanmoins, ignorons l’exagération de la Commission européenne quant au nombre d’enfants concernés, car le chiffre publié par l’OMS reste très élevé et doit être pris en compte.

Le chiffre publié par l’OMS suggère que plus de 6 millions d’enfants dans l’UE souffrent d’abus sexuels.

Par conséquent, nous pouvons convenir que l’UE doit faire quelque chose pour mettre fin aux abus sexuels sur les enfants.

2. La surveillance peut-elle aider à lutter contre les abus sexuels sur les enfants ?

Où les abus ont-ils lieu ?

Une autre question très importante lors de l’introduction de mesures de surveillance pour lutter contre les abus sexuels sur les enfants est celle de l’efficacité.

Si la surveillance de nos communications privées (balayage CSAM) permettait de sauver des millions d’enfants en Europe des abus sexuels, de nombreuses personnes seraient d’accord avec cette mesure. Mais est-ce vraiment le cas ?

Sur le même site web où la Commission européenne affirme qu‘“un enfant sur cinq” est concerné, elle déclare également que “entre 70 et 85 % des enfants connaissent leur agresseur. La grande majorité des enfants sont victimes de personnes en qui ils ont confiance.”

Cela soulève la question suivante : En quoi le fait de scanner le CSAM sur chaque message de chat va-t-il aider à prévenir les abus sexuels sur les enfants au sein de la famille, du club de sport ou de l’église ?

La Commission européenne laisse cette question sans réponse.

Combien d’ordonnances de surveillance concernent la protection des enfants ?

Pour savoir si la surveillance des messages privés à la recherche de matériel CSA peut aider à lutter contre les abus sexuels sur les enfants, nous devons examiner les données de surveillance réelles qui sont déjà disponibles.

En tant que fournisseur de messagerie basé en Allemagne, nous disposons de telles données. Notre rapport de transparence montre que nous recevons régulièrement des ordres de surveillance des télécommunications de la part des autorités allemandes afin de poursuivre des criminels potentiels.

On pourrait penser que Tutanota, en tant que service de messagerie électronique crypté de bout en bout et axé sur la protection de la vie privée, serait le lieu de prédilection des délinquants, par exemple pour le partage de CSAM.

Par conséquent, on pourrait s’attendre à ce que le nombre d’ordonnances judiciaires émises en matière de “pédopornographie” soit élevé.

En 2021, nous avons reçu UNE ordonnance de surveillance des télécommunications fondée sur la suspicion que le compte était utilisé à des fins de “pédopornographie”.

Cela représente 1,3 % de toutes les ordonnances que nous avons reçues en 2021. Plus de deux tiers des ordres ont été émis en rapport avec des “ransomware” ; quelques cas individuels en rapport avec des violations de droits d’auteur, la préparation de crimes graves, le chantage et la terreur.

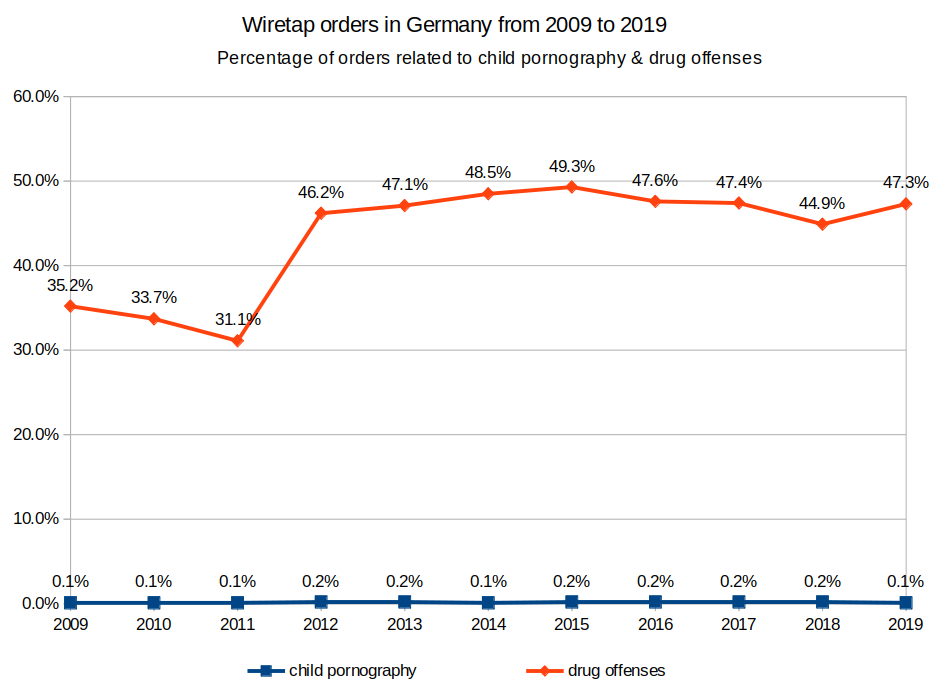

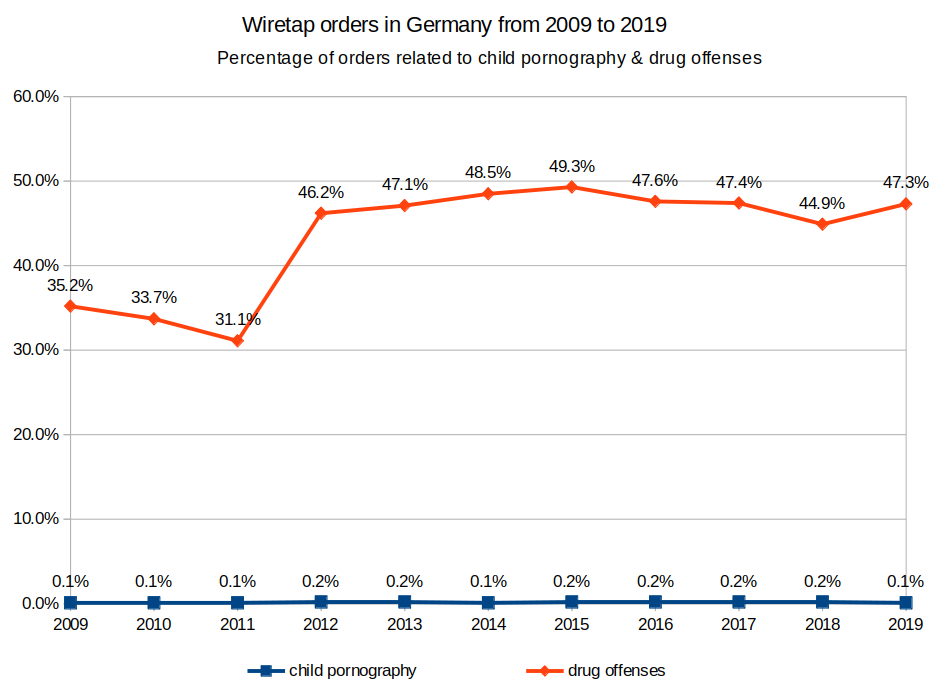

Les chiffres publiés par l’Office fédéral allemand de la justice dressent un tableau similaire : En Allemagne, plus de 47,3 % des mesures de surveillance des télécommunications selon le § 100a StPO ont été ordonnées pour trouver des suspects d’infractions liées aux drogues en 2019. Seulement 0,1 pour cent des ordonnances - soit 21( !) au total - ont été émises en relation avec la “pornographie enfantine”.

En 2019, il y a eu 13.670 cas de maltraitance d’enfants, selon lastatistique du ministère fédéral allemand de l’Intérieur en Allemagne.

Si l’on prend ces chiffres dans leur ensemble, il y a eu 13.670 enfants maltraités en Allemagne en 2019. Dans seulement 21 de ces cas, une ordonnance de surveillance des télécommunications a été émise.

Il devient évident que la surveillance des télécommunications (qui est déjà possible) ne joue pas un rôle significatif pour traquer les auteurs d’abus.

La conclusion ici est évidente : ” Plus de surveillance ” n’apportera pas ” plus de sécurité ” aux enfants en Europe.

3. L’Europe - une plaque tournante pour le CSAM ?

Comme pour l’affirmation “un sur cinq”, la Commission européenne affirme que 90 % du matériel pédopornographique est hébergé sur des serveurs européens. Une fois encore, la Commission européenne utilise cette affirmation pour justifier son projet d’analyse du CSAM.

Cependant, même les experts dans ce domaine, l’association écologique allemande qui travaille avec les autorités pour retirer le CSAM (Child Sexual Abuse Material), déclarent que “selon eux, les chiffres sont très éloignés des 90 % annoncés”. Alexandra Koch-Skiba, de l’association écologique,déclare également : “Selon nous, le projet a le potentiel de créer un laissez-passer pour la surveillance gouvernementale. C’est inefficace et illégal. Une protection durable des enfants et des jeunes nécessiterait au contraire davantage de personnel pour les enquêtes et des poursuites complètes.”

Même les responsables allemands de l’application des loiscritiquent les plans de l’UE à huis clos. S’il ne s’agit que d’avoir plus de cas et d’attraper plus d’auteurs, alors on n’a pas besoin d’un tel empiètement sur les droits fondamentaux”, déclare un autre enquêteur de longue date sur les abus envers les enfants.

Exagération à la limite du fake news

Il est incroyable que la Commission européenne utilise ces exagérations pour faire basculer l’opinion publique en faveur du balayage du CSAM. Il semble que l’argument “protéger les enfants” soit utilisé pour introduire des mécanismes de surveillance de type chinois. Ici, en Europe.

Mais l’Europe n’est pas la Chine.

Qu’est-ce que je peux faire ?

En Allemagne, il y a au moins une étincelle d’espoir. La fuite d’un document sur le “contrôle des chats” laisse penser que le gouvernement allemand actuel s’opposera à la proposition de la Commission européenne.

En tant que citoyens européens et membres de la société civile, nous devons maintenant faire pression sur les législateurs pour qu’ils s’opposent à une législation qui soumettra chaque courriel et chaque message de chat que nous envoyons à une surveillance constante.

Et vous pouvez faire beaucoup pour nous aider à lutter pour la vie privée

-

- Partagez cet article de blog pour que tout le monde comprenne les fausses affirmations de la Commission européenne.

-

- Partagez la vidéo de “Digitale Gesellschaft” pour que tout le monde comprenne que ce texte législatif est complètement disproportionné et qu’il existe de bien meilleures façons de protéger les enfants.

-

- Appelez ou envoyez un courriel à votre représentant européen pour faire entendre votre voix : Arrêtez la numérisation de CSAM sur mon appareil personnel !

Que signifie le sigle CSAM ?

CSAM désigne le matériel pédopornographique, c’est-à-dire les images représentant des abus sexuels et l’exploitation d’enfants.

Qui recherche le CSAM ?

Plusieurs services recherchent le matériel CSAM sur leurs serveurs, par exempleGoogle. Depuis le 6 juillet 2021, les entreprises de l’UE peuvent également rechercher volontairement du matériel CSA.

Quelles sont les conséquences du balayage de CSAM ?

Le balayage côté client pour le matériel CSA transformera vos propres appareils en machines de surveillance. Si le balayage CSAM devient obligatoire, tous les messages de discussion et tous les courriels que vous avez envoyés seront balayés et lus par d’autres. Le balayage côté client porte donc atteinte à votre droit à la vie privée.