Rotten Apples: iOS 15, persönlicher Datenschutz und der andauernde Kampf gegen CSAM.

“iOS 15 In touch. In the moment.”

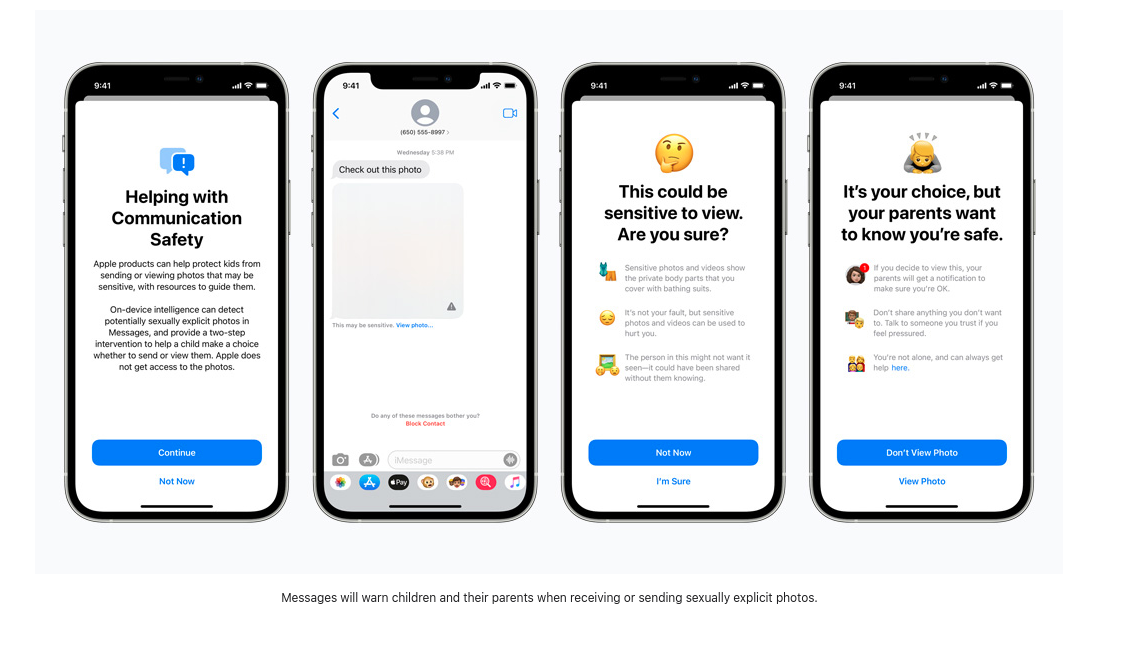

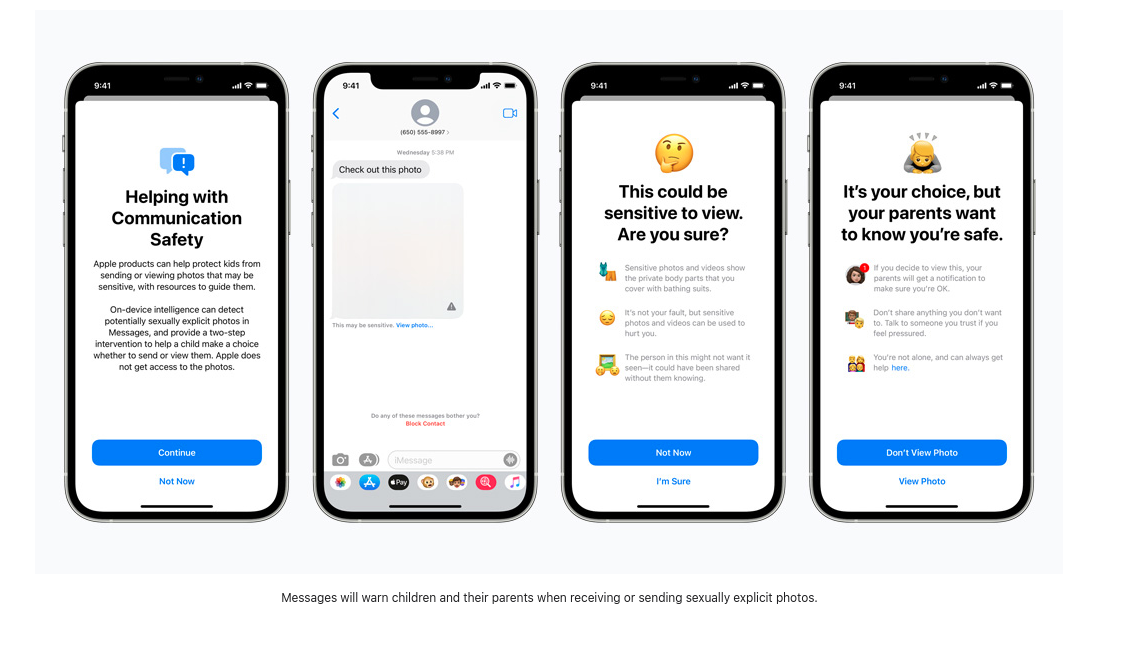

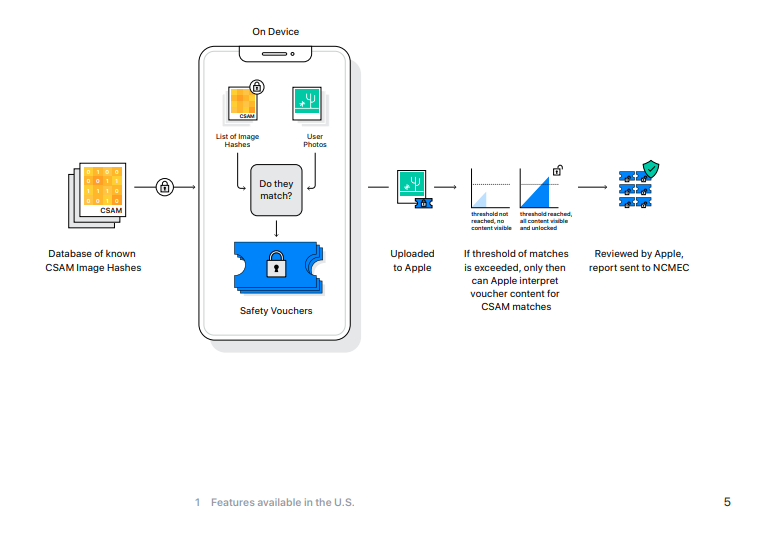

Mit diesem neuen Betriebssystem-Update erhalten wir anscheinend drei neue Funktionen, die laut Apple “helfen, Kinder vor Pädophilen zu schützen, die Kommunikationstools nutzen, um sie auszubeuten, und die Verbreitung von Material über sexuellen Kindesmissbrauch (CSAM) einzuschränken”. Die erste zielt darauf ab, die “Kommunikationssicherheit in Nachrichten” zu verbessern, die neue Werkzeuge zur elterlichen Kontrolle und Warnungen hinzufügt, die angezeigt werden, wenn sexuell explizites Material gesendet oder empfangen wird. Die zweite ist eine Funktion, die einen Algorithmus zur Erkennung von CSAM verwendet, um die Fotos-App auf Bild-Hashes zu überprüfen, die mit bekannten CSAM-Hashes übereinstimmen. Die dritte neue Kinderschutzfunktion führt eine Suchfunktion ein, die den Nutzern Ressourcen zur Meldung von CSAM zur Verfügung stellt und aktiv eingreift, wenn Nutzer nach einem Begriff suchen, der mit CSAM in Verbindung steht.

Nehmen wir uns einen Moment Zeit, um im Detail zu erklären, was diese Funktionen bewirken sollen und wie sie es tun.

Keine unaufgeforderten D *ck-Pics mehr.

Eine aktuelle Studie von Thorn berichtet, dass “selbst erstelltes Material über sexuellen Kindesmissbrauch (SG-CSAM) ein schnell wachsender Bereich von Material über sexuellen Kindesmissbrauch (CSAM) ist, das online im Umlauf ist und von Gemeinschaften von Missbrauchstätern konsumiert wird”, und dass Apples neuer “erweiterter Schutz für Kinder” darauf abzielt, das Wachstum dieser Praxis zu bremsen. Der Austausch von “Nacktfotos” zwischen Liebespartnern verbreitet sich oft in einer Gruppe von Gleichaltrigen und kann in Fällen von “Rache-Pornos” im Internet landen. Apple wird nun damit beginnen, Kindern (oder Nutzern mit aktivierten Sicherheitsfunktionen) Warnungen vor dem Betrachten oder Versenden expliziter Bilder anzuzeigen. Wird ein Bild angesehen oder verschickt, erhält das Gerät der Eltern eine Benachrichtigung über diese Aktivität.

Die eingehenden Bilder werden von einem maschinellen Lernprogramm auf dem Gerät gescannt, das verdächtiges Material kennzeichnet und “lernt”, um festzustellen, ob künftige Bilder in die gleiche Kategorie fallen. Wer diesen Algorithmus steuert und welchen Einfluss die Nutzer darauf haben, wie er verdächtige Bilder meldet, wird nicht bekannt gegeben. Apple schreibt, dass diese “Funktion so konzipiert ist, dass Apple keinen Zugriff auf die Nachrichten erhält”. Mit diesem neuen Update wird Apple also damit beginnen, verschlüsselte Nachrichten zu überprüfen, die über iMessage gesendet werden, um Eltern und Jugendliche vor schädlichen Online-Inhalten zu warnen.

Oberflächlich betrachtet mag dies nicht gefährlich erscheinen, aber wenn dieselbe Scantechnologie eingesetzt würde, um verschlüsselte Nachrichten auf abweichende politische Meinungen, religiöse Minderheitensprachen oder Diskussionen über die sexuelle Orientierung zu überprüfen, könnte diese neue Überwachungssoftware auf dem Gerät leicht verändert und missbraucht werden.

Scannen, um die Ausbreitung zu stoppen.

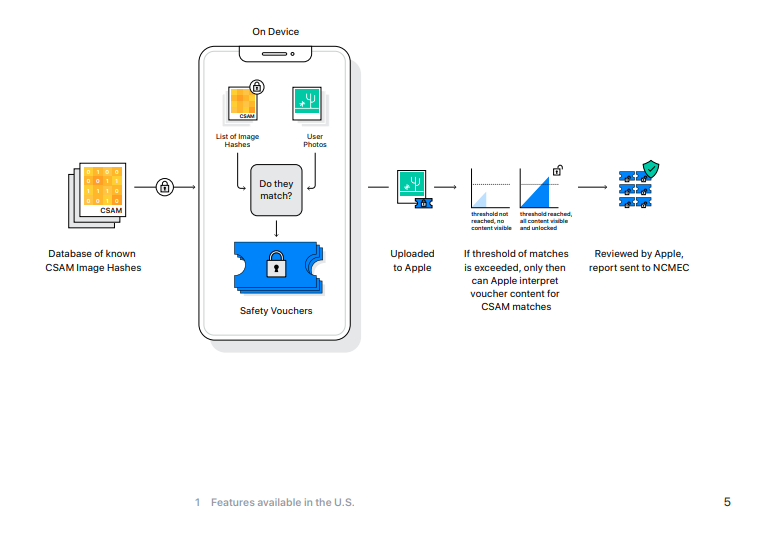

Nach Angaben der Electronic Frontier Foundation “besitzt Apple zwar die Schlüssel, um die in iCloud Photos gespeicherten Fotos einzusehen, scannt diese Bilder aber nicht”. Das wird sich mit iOS 15 ändern, und wenn Sie derzeit Ihre Fotos in Apples iCloud sichern, werden diese Fotos gehasht und diese Werte mit denen bekannter CSAM verglichen.

Wenn ein iOS-Gerät die iCloud-Backup-Funktion aktiviert hat, beginnt diese Überprüfung zunächst auf dem lokalen Rechner. Das neue iOS 15 enthält eine Version der CSAM-Hash-Datenbank des National Center for Missing and Exploited Children. Bei unverschlüsselten Bildern, die mit einem iPhone aufgenommen wurden, werden die Hash-Werte (ein *hoffentlich * eindeutiger numerischer Wert, der das Bild repräsentiert) mit denen der NCMEC-Datenbank verglichen. Im Falle einer Übereinstimmung werden die Fotos an menschliche Prüfer bei Apple weitergeleitet. Wenn diese Prüfer die Übereinstimmung bestätigen können, wird das Bild an das NCMEC und die Strafverfolgungsbehörden gesendet, und das Konto des Nutzers wird deaktiviert.

Wenn Sie die iCloud zur Sicherung Ihrer Fotos verwenden, werden Ihre Fotos mit dieser Datenbank abgeglichen, ohne dass ein hinreichender Verdacht besteht, dass Sie eine Straftat begangen haben oder an einer solchen beteiligt waren.

Sehen Sie sich dieses Foto [nicht] an.

Die letzte neue Funktion für die Sicherheit von Kindern ist ein Update für Siri und die Suche, das Anleitungen zum Melden von CSAM-Fällen und zum “Eingreifen” bietet, wenn Nutzer nach Begriffen suchen, die mit CSAM in Verbindung stehen.

Die genaue Wortliste ist nicht öffentlich, und wir wissen nicht, ob die von den Nutzern gemeldeten Begriffe zum Training des maschinellen Suchmonitors verwendet werden.

Es gibt nur sehr wenige Informationen darüber, welche Art von Begriffen diese Warnungen auslösen und was passiert, wenn sie ignoriert werden. Im Falle der Bild-Hashing-Überprüfung wird ein Apple-Mitarbeiter übereinstimmende Ergebnisse ermitteln, aber wir wissen nicht, welche weiteren Maßnahmen bei Suchergebnissen ergriffen werden. Wenn man sich die offizielle Apple-Presseseite zu diesen neuen Funktionen ansieht, besteht die Diskussion über überwachte Suchbegriffe aus vier kurzen Sätzen. Es wird interessant sein zu sehen, ob diese Liste auf der Grundlage der von den Benutzern gemeldeten Begriffe wächst oder wie Apple diesen Algorithmus trainiert.

Wenn Sie nichts zu verbergen haben…

Mit diesen drei neuen Funktionen werden Apple-Benutzer und diejenigen, die mit ihnen Nachrichten und Bilder verschicken, dem Scannen ihrer verschlüsselten Nachrichten und der Überwachung ihrer privaten Suchbegriffe ausgesetzt, und das alles, ohne dass ein Verdacht oder ein Beweis für ein Verbrechen vorliegt. Es ist eine Sache, wenn Apple und andere große Technologieunternehmen die Hashes der auf ihren Servern gespeicherten Bilder scannen. Schließlich sind diese Server Firmeneigentum und Sie müssen sie nicht benutzen.

Aber wenn diese neuen Überwachungsfunktionen auf lokale Geräte übertragen werden, wird die Tatsache ignoriert, dass Sie, der Besitzer des Geräts, Hunderte von Dollar (oder Euro) für ein Gerät bezahlt haben, das Ihr Verhalten überwacht. Sie haben keine große Wahl bei den Prozessen, die auf einem Teil Ihres persönlichen Eigentums ablaufen. Diese ‘Verbesserung’ geht sogar noch weiter in Richtung des Modells ‘Produkt als Dienstleistung’, das in der Welt der proprietären Software bereits zum Mainstream geworden ist.

Mit dieser neuen Version von iOS untergräbt Apple die Sicherheit seiner einst gepriesenen Messaging-Plattform. Eine Ende-zu-Ende-verschlüsselte Messaging-App, die die Bilder scannt, sobald sie das Zielgerät erreichen, ist eine gefährliche Lüge, die nichts zum Schutz der Sicherheit und Privatsphäre der Apple-Nutzer beiträgt. Katastrophal ist außerdem, dass eine solche Software von Nationalstaaten angewendet werden kann, die die Menschenrechte nicht respektieren.

IOS 15 setzt einen gefährlichen Standard für die Zukunft der Ende-zu-Ende-Verschlüsselung.

Der Schutz der Kinder wird das Mantra sein, das uns in eine Welt der zunehmenden Überwachung und der Auflösung der persönlichen Privatsphäre führt. Ja, CSAM ist verabscheuungswürdig und sollte in vollem Umfang strafrechtlich verfolgt werden, aber die Existenz von CSAM rechtfertigt nicht den Verzicht auf eine nuancierte Diskussion über Privatsphäre, Datenverschlüsselung, sexuelle Gewalt und Überwachung.

Matthew Green warnt vor den Folgen dieser Änderungen: “Unabhängig davon, was Apples langfristige Pläne sind, haben sie ein sehr klares Signal gesendet. Ihrer (sehr einflussreichen) Meinung nach ist es sicher, Systeme zu bauen, die die Telefone der Nutzer nach verbotenen Inhalten durchsuchen. Das ist die Botschaft, die sie an Regierungen, konkurrierende Dienste, China und Sie senden.”