如何阻止 LinkedIn 利用你的数据训练人工智能?

如果你没有手动退出 LinkedIn AI,它可能会使用你的简历和个人资料信息来训练微软公司的人工智能。不,你没有选择加入。现在就采取行动,阻止这一切。

如何阻止 LinkedIn 利用你的数据训练人工智能

如果您错过了在 2025 年 11 月 3 日之前选择退出的机会,您仍然可以通过以下步骤退出。请注意,这将阻止未来数据的使用,但不会删除已经用于训练 AI 模型的数据。

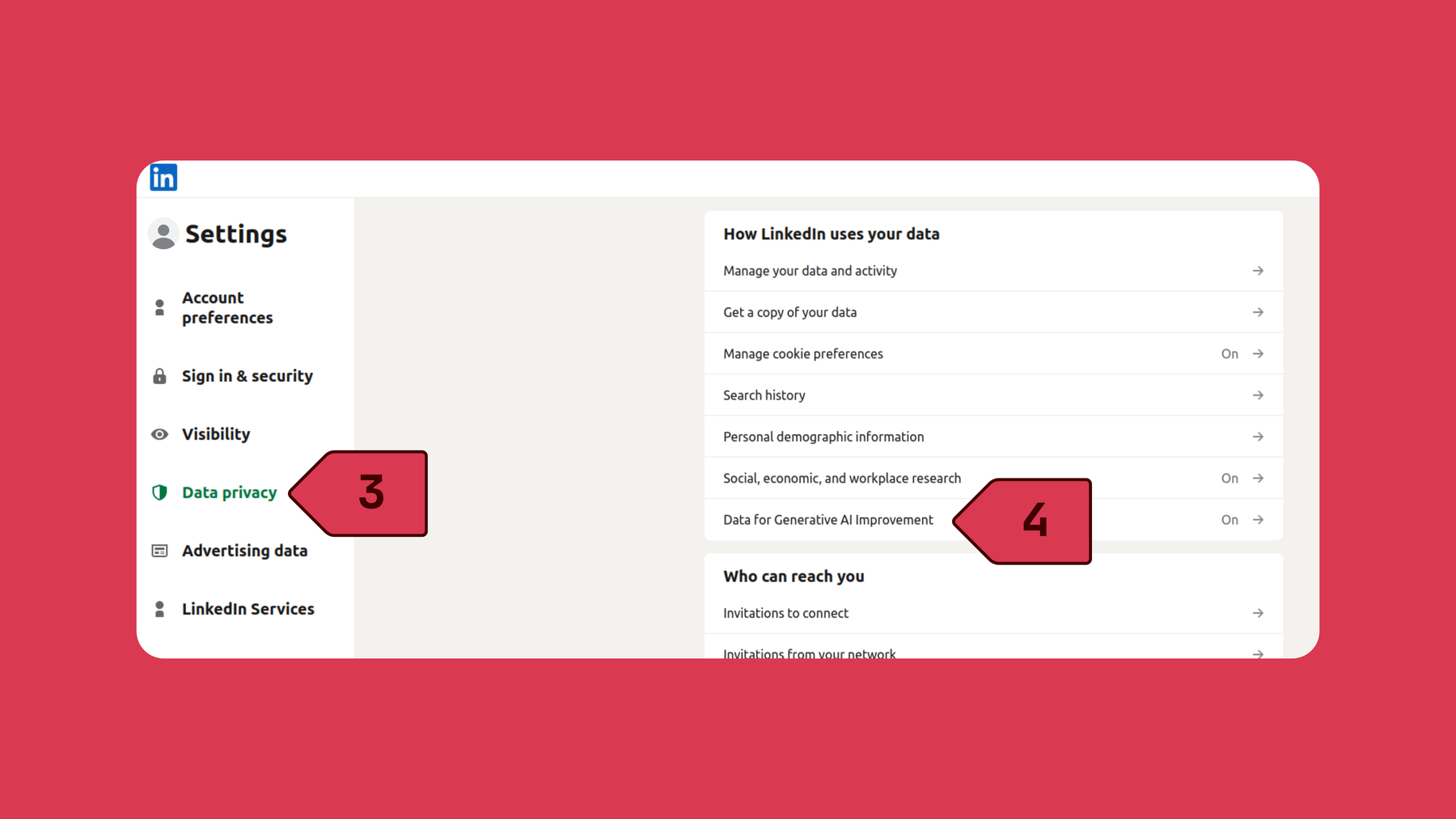

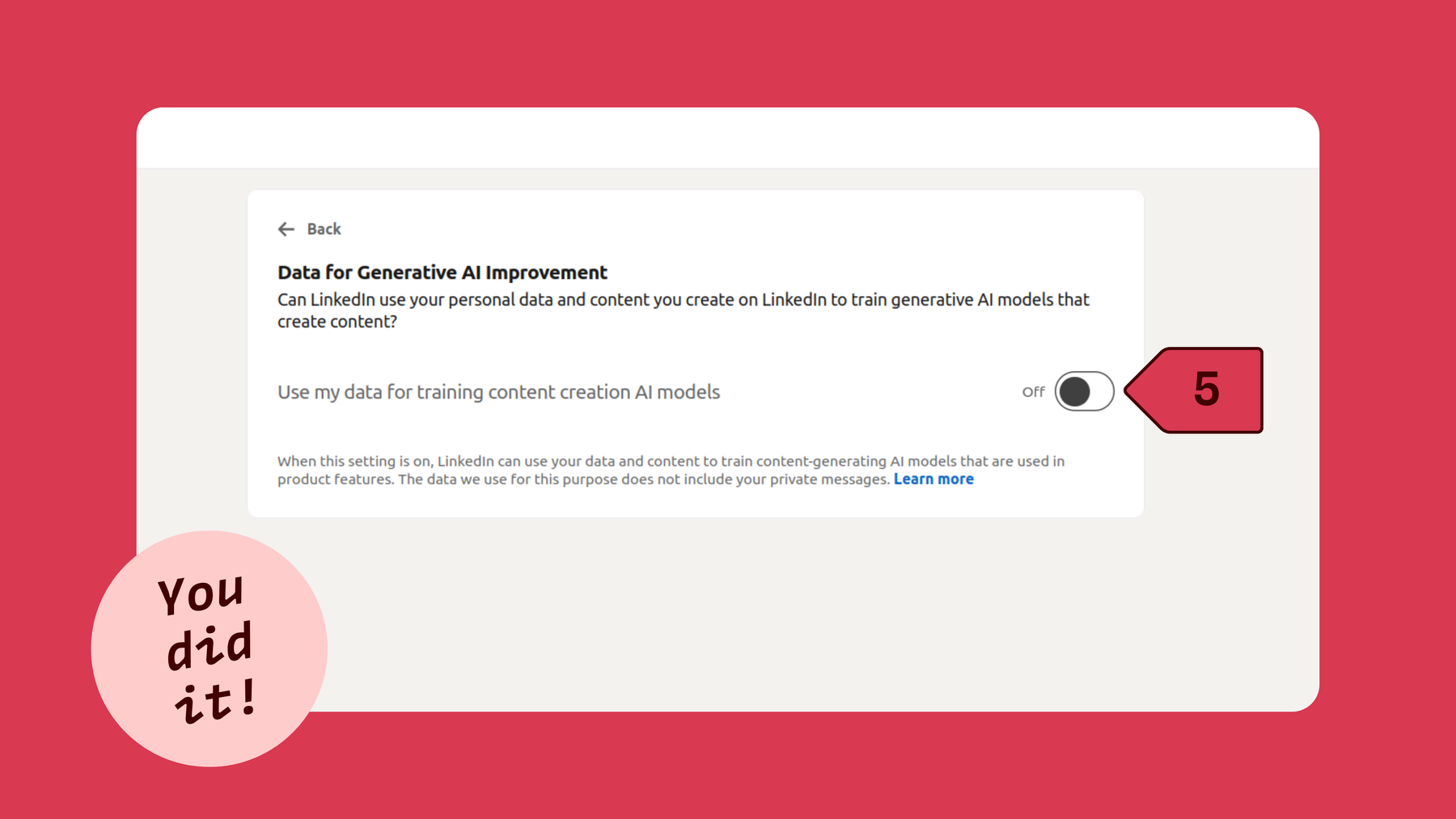

1.登录 LinkedIn 账户 2.点击个人主页图片 3.点击 设置与隐私 4. 选择 数据隐私 5.点击 用于生成人工智能改进的数据 6.在Use my data for training content creation AI models旁边点击关闭切换按钮

退出的快速链接 :点击此链接,阻止 LinkedIn 将您的数据用于人工智能。

LinkedIn 是下一个计划悄悄开始利用欧洲用户数据来训练 AI 模型的大型科技公司。去年9 月 18 日,LinkedIn 宣布,从 2025 年 11 月 3 日开始,来自欧盟、欧洲经济区和瑞士的用户数据(最早可追溯到 2003 年)将被用于训练其及其附属公司的 AI 模型。 这意味着你的工作经历、简历和 LinkedIn 参与度等信息将被收集并用于训练人工智能模型。LinkedIn并没有给用户选择是否明确选择加入或退出这种数据处理的机会,而是** 选择默认让所有人加入**(就像 2024 年在其他地区所做的那样),声称根据欧盟的 GDPR,这种数据处理是合法权益。微软旗下的科技巨头LinkedIn因误导数百万用户为人工智能附加组件支付45%的高额费用而在澳大利亚遭到起诉,还因通过Microsoft Recall每隔几秒截取屏幕截图而遭到抨击,LinkedIn的这一声明让许多人担心自己的数据会被如何使用,以及LinkedIn如何简单地决定使用这些数据,而不是礼貌地询问。因此,现在用户必须采取行动,否则就只能眼睁睁地看着自己的数据被滥用。

LinkedIn 的重大胜利:为在欧盟、欧洲经济区和瑞士使用数据进行人工智能培训开绿灯

2024 年 11 月,LinkedIn 开始使用全球用户的个人数据来训练其生成式人工智能模型。当时,欧洲人感到很安全,因为 GDPR 似乎可以保护他们的数据不被滥用。因为那时,居住在欧盟、欧洲经济区和瑞士的用户数据被排除在外。但根据公告,自 2025 年底起,LinkedIn 将这些地区的用户数据也用于人工智能训练—这对 LinkedIn 来说是个胜利,但对用户隐私来说却是个巨大损失。

由于这一消息令人震惊,欧盟的隐私专家已经发出警告,用户必须手动进入 LinkedIn 账户设置,并关闭 “用于生成 AI 改进的数据 “选项。

LinkedIn 收集哪些数据用于人工智能训练?

如果你在 2025 年 11 月 3 日之前没有手动选择将你的数据用于人工智能训练,那么我们在下面列出的所有追溯到 2003 年的数据都可以用于训练 LinkedIn 及其附属公司的人工智能模型。如果您还没有选择退出,您仍然可以选择退出,但退出前收集的数据不会从 LinkedIn 的人工智能模型中删除,这意味着您的个人数据将永久保留在训练数据集中。

-

您的所有个人资料数据:姓名、个人照片、当前和过去的工作、学历、技能、位置、背书、出版物、专利和推荐。

-

您的内容:您撰写或分享的帖子、文章、评论、贡献和投票回复。

-

您的工作数据:您的简历、您申请过的工作、申请数据以及对工作筛选问题的回复。

-

您的群组数据:群组活动和消息。

-

您的反馈:您提供的反馈,包括回复和评分。

注意: LinkedIn 已声明,您的私人信息、登录信息、支付方式和高度敏感数据将不在数据收集范围内。

如何在任何设备上退出 LinkedIn 利用您的数据为其人工智能项目提供支持的行为

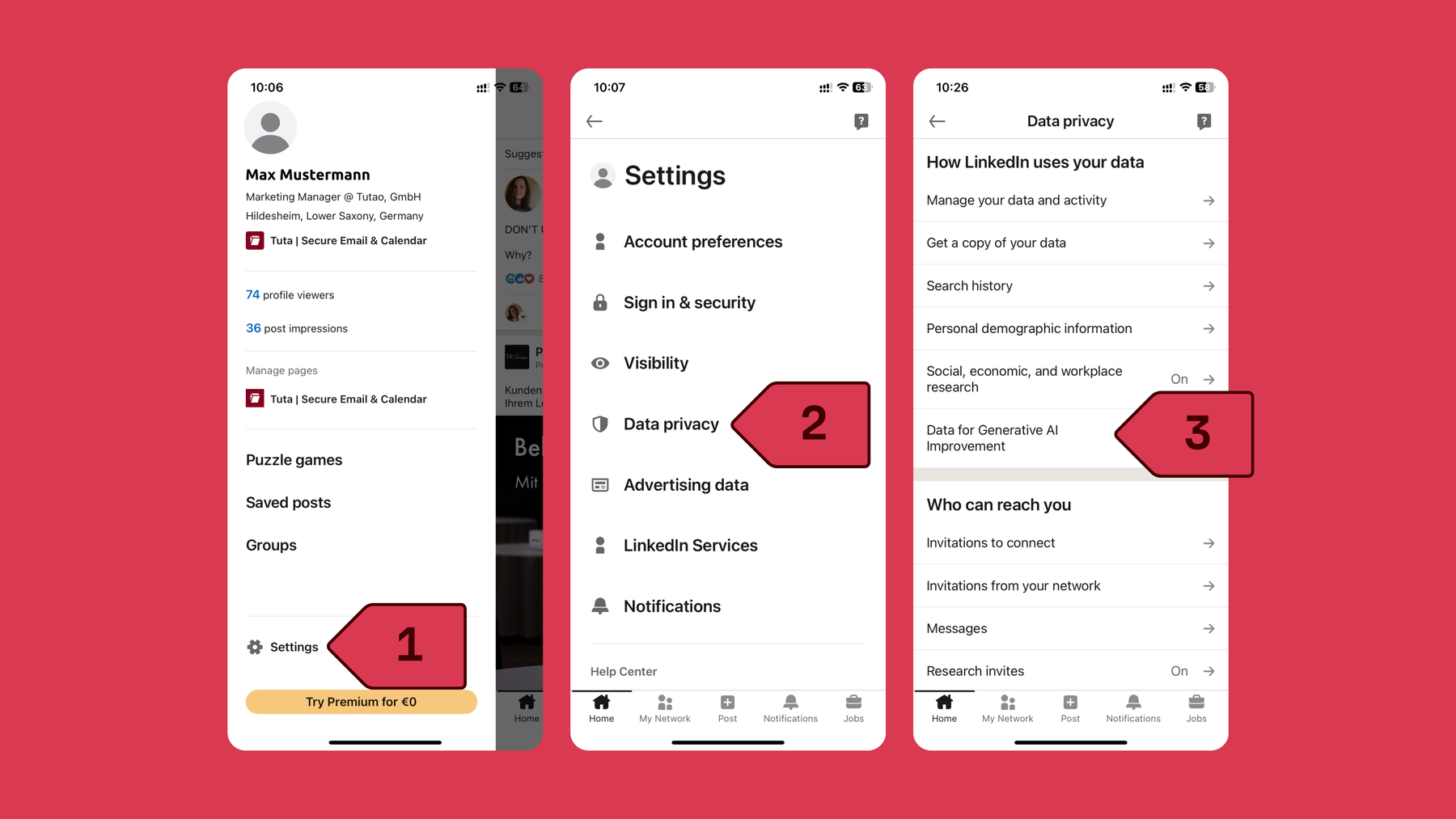

如何在 iPhone 上退出 LinkedIn AI

请按照以下步骤选择退出 LinkedIn 使用您的数据在 iPhone 应用程序上训练 AI。截图:LinkedIn。

- 打开手机上的 LinkedIn 应用程序并登录账户

- 点击个人资料图片

- 点击打开_设置_

- 选择_数据隐私_

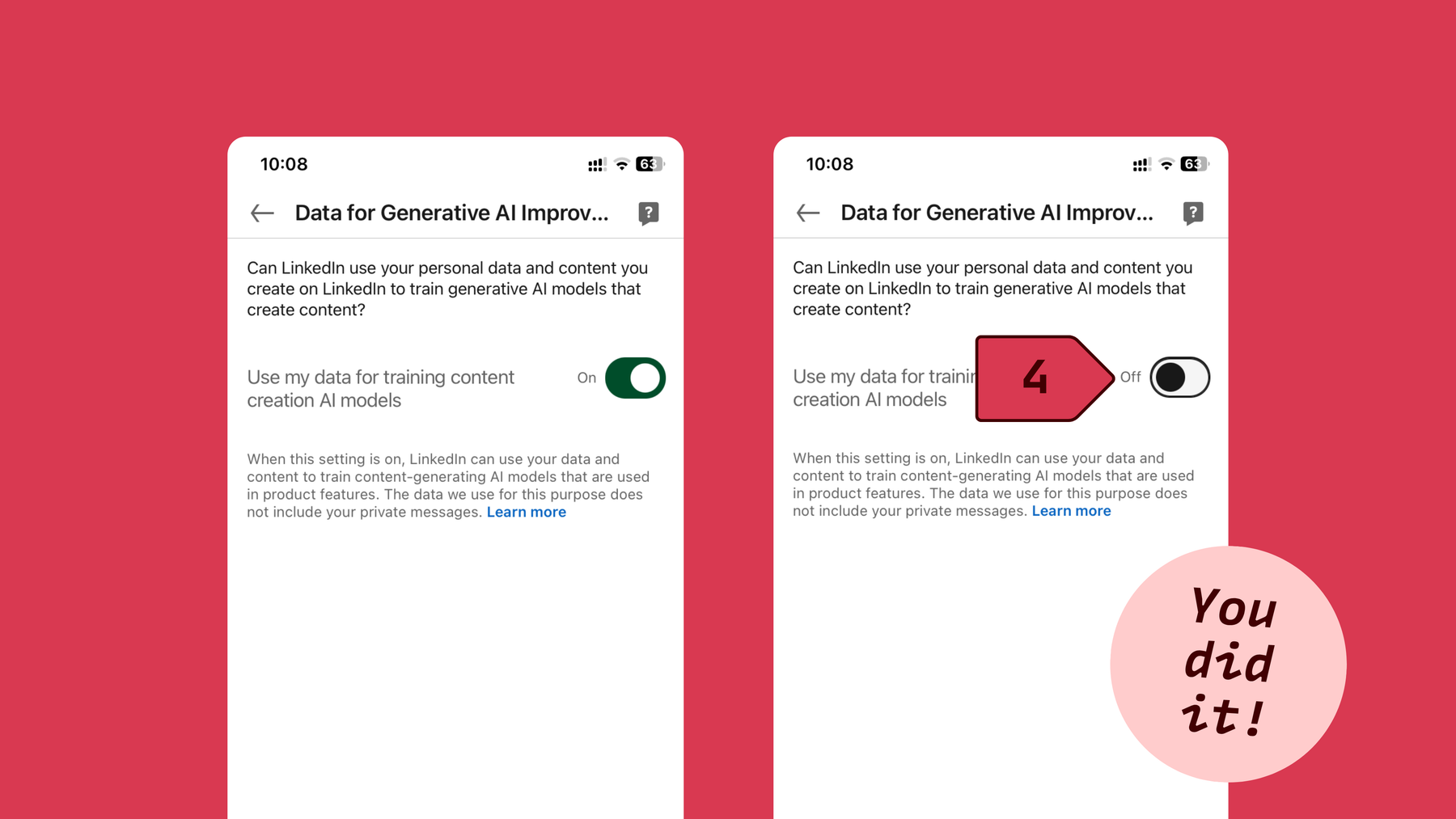

- 单击 “用于改进生成式人工智能的数据

- 在 “将_我的数据用于训练内容创建 AI 模型_“旁边,点击关闭切换按钮

在 Android 上退出 LinkedIn 的人工智能

- 打开 Android 上的 LinkedIn 应用程序并登录账户

- 点击个人资料图片

- 点击打开设置

- 选择_数据和隐私_

- 单击 “用于改进生成式人工智能的数据

- 在 “将_我的数据用于训练内容创建 AI 模型_“旁边,点击关闭切换按钮

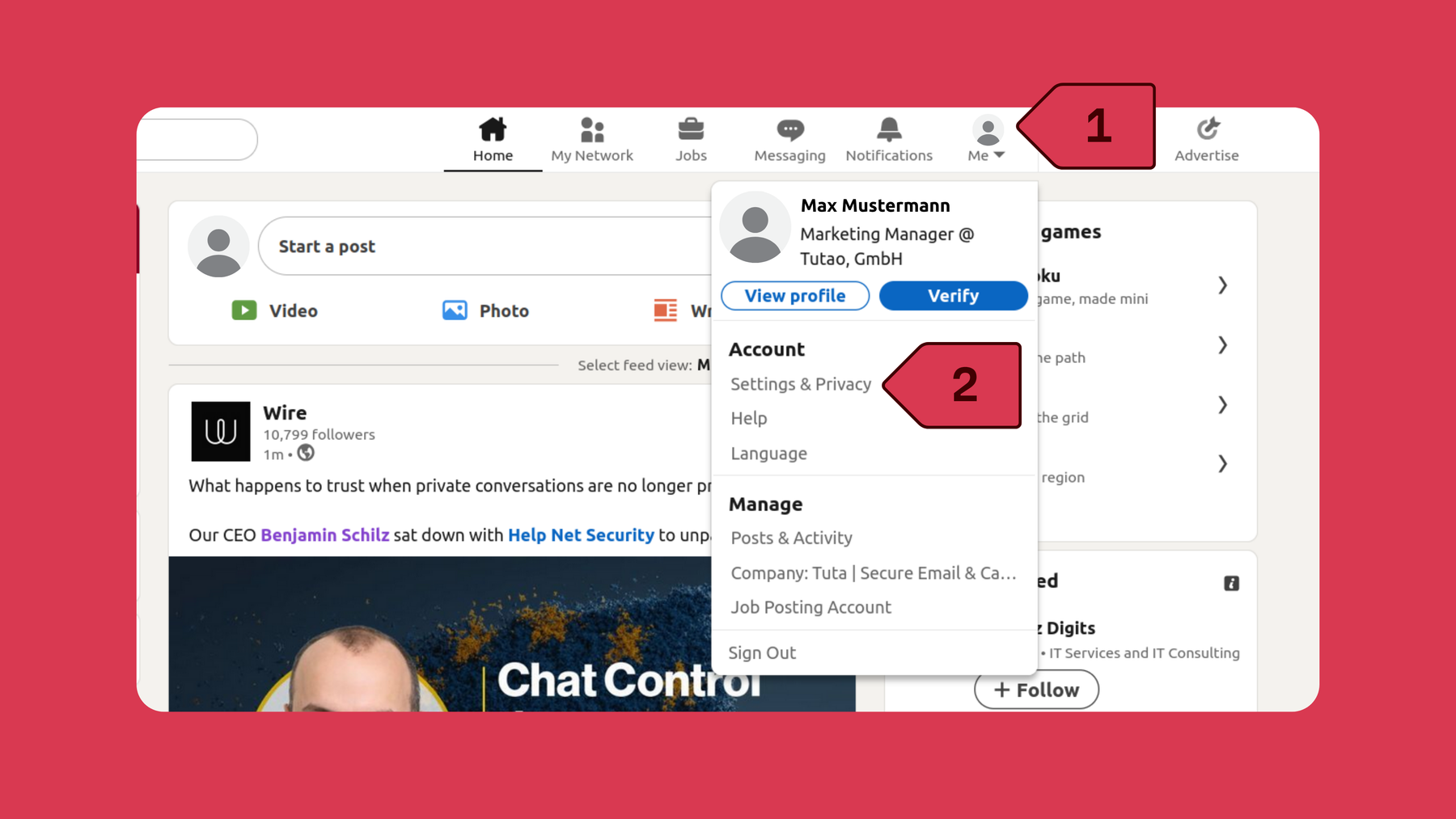

通过浏览器阻止 LinkedIn 将您的数据用于 AI 训练

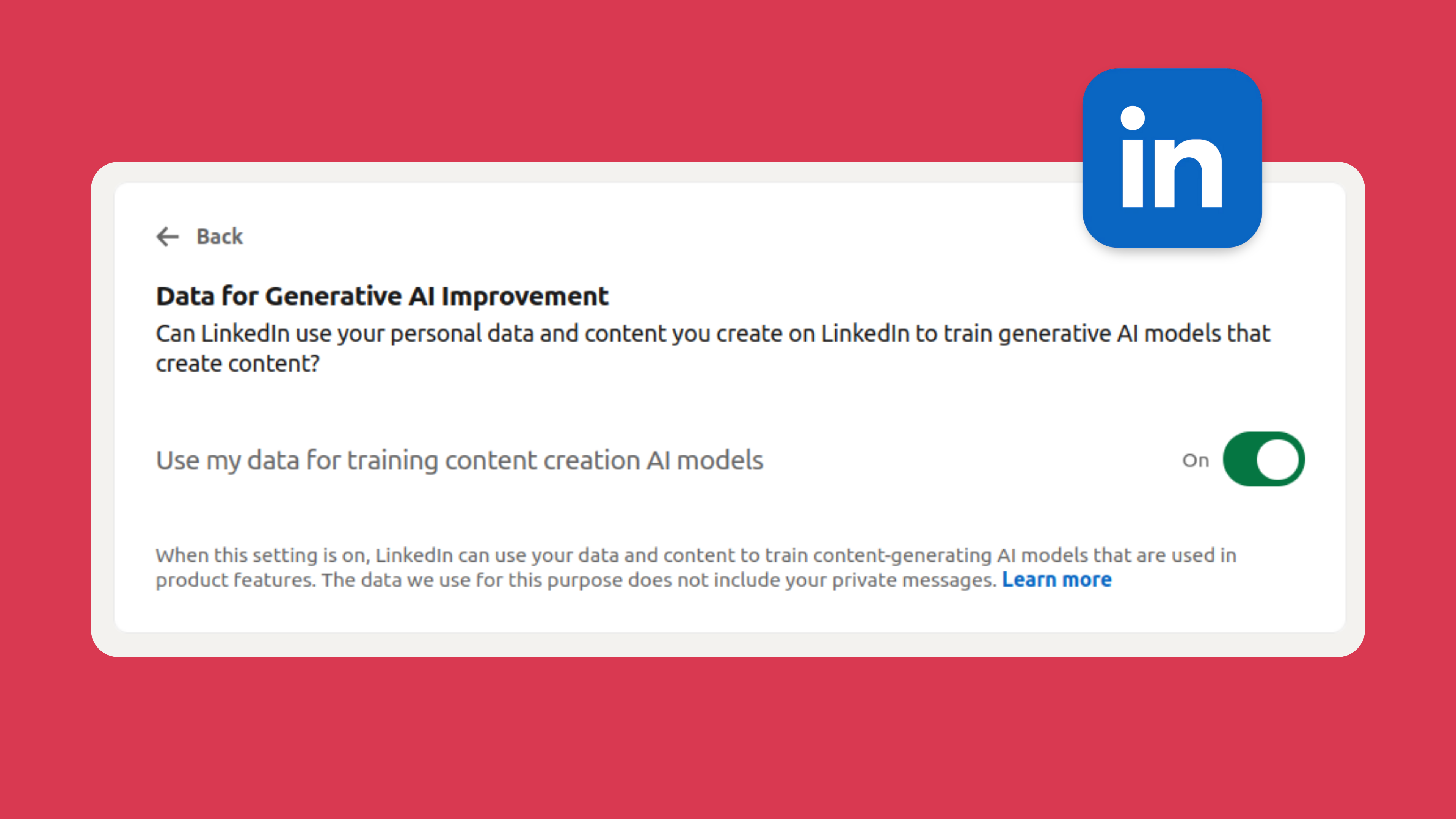

请按照以下步骤选择退出 LinkedIn 将您的数据用于从网页浏览器训练内容创建 AI 模型。屏幕截图:LinkedIn。

1.登录 LinkedIn 账户 2.点击个人资料图片 3.点击 设置和隐私 4. 选择 数据隐私 5.点击 用于生成式人工智能改进的数据 6.在Use my data for training content creation AI models 旁边点击关闭拨动开关。

除了选择退出未来数据用于人工智能目的之外,您还可以填写这份LinkedIn 数据处理反对表,拒绝或要求限制对您个人数据的处理。

过去对 LinkedIn 偷偷引入人工智能选择加入的震惊

2024 年,当 LinkedIn 的用户得知他们的数据被默认用于训练 AI 模型时,LinkedIn 遭到了用户的强烈反对。更令人担忧的是,“退出 “选项并不是一个新设置,但却让 LinkedIn 用户大吃一惊,因为他们并不知道自己的数据已被用于训练人工智能。

2024 年 9 月 18 日,404 媒体报道称,LinkedIn 在开始收集用户数据之前甚至没有更新其隐私政策。当 404 Media 就此事联系 LinkedIn 时,该公司告诉 404,它 “很快 “就会更新其服务条款。LinkedIn 的回应充其量也只能说是极其可疑。随后,在同一天,LinkedIn 悄然发布了一篇由其法律总顾问 Blake Lawit 撰写的博文,宣布将于 2024 年 11 月 20 日对其隐私政策和服务条款进行修改。对 LinkedIn用户协议和隐私政策的修改解释了公司如何将用户数据用于人工智能。

人们本以为这个微软旗下的平台会先宣布隐私政策的变更,然后再收集用户数据,但在这种情况下,似乎并非如此。

隐私与人工智能

LinkedIn 现在可以收集欧洲用户的数据用于人工智能训练,这可能是个新闻,但不幸的是,这是一种常见的做法,你的数据很可能也被其他网站用于人工智能训练。即使在通过 GDPR(在一定程度上)保护公民数据的欧盟,科技巨头们仍然会找到漏洞,收集用户数据来开发他们的人工智能模型。

例如,Meta公司最初计划使用欧盟用户的Facebook和Instagram数据来训练Meta人工智能,但从2025年5月27日起,Meta公司开始使用欧洲用户的Facebook和Instagram公开数据进行人工智能训练。不幸的是,对于美国等世界其他地区的 Facebook 用户来说,由于美国没有像欧盟 GDPR 这样的数据隐私法,Meta 旗下的 Facebook 在用户数据方面拥有更大的影响力,基本上可以想怎么用就怎么用。例如,用户数据被用于人工智能训练,而人们却无法选择退出。这不仅引发了大量的数据隐私问题,也凸显了用户在数据使用方面缺乏选择和自由。

当然,Meta 并不是唯一一家滥用用户数据的科技巨头,谷歌和人工智能电子邮件作者也是如此。一位 Gmail 用户分享了他们与谷歌双子座人工智能聊天机器人的一段对话。对话中令人震惊的是,聊天机器人使用的数据来自 Gmail 用户的电子邮件。尽管 Gmail 用户从未授权或选择允许大语言模型访问他们的个人邮箱。

从以上两个例子中我们可以看出,这些大科技提供商只想着增加自己的利益,而不是从道德的角度出发。当涉及到大科技、利润和技术进步时,就像这种疯狂抢搭人工智能列车的行为(往往未经你的同意),所有的界限都被跳过了。

最后的想法

LinkedIn 对用户信息处理方式的改变可能会让一些使用该平台的人感到意外,但遗憾的是,这与许多科技公司处理数据的方式并无不同。LinkedIn 是又一家加入人工智能潮流、使用用户信息训练模型的科技公司。

如果你经常访问图塔的博客,你就会知道,说到大型科技公司,它们的商业模式就是利用你的个人信息牟利。他们对隐私的无忧无虑遵循的是一种屡试不爽的方法:收集尽可能多的数据,然后卖给广告商,广告商再向你投放广告。冲洗、清洗、重复。一个完美的例子就是Meta 和谷歌如何免费提供其广泛的产品,但代价是用你的数据而不是金钱来支付。而现在,随着每家公司都竞相利用人工智能,你的数据不仅被用来从广告中获利,而且对这些公司来说显得更有价值。

这种开发人工智能和利用数据的热潮是一种不会消失的趋势。我们可以学到的是,流行的网络公司,如 Meta、谷歌和微软等,总是把利润放在第一位,而把道德放在第二位。

话虽如此,如果你选择继续使用这些平台,最好还是了解并及时更新其使用条款和隐私政策的任何变化,这对我们这些不懂法律的人来说是件麻烦事,但却是必要的。特别是如果你担心自己的数据和隐私。

如果你真的担心自己的隐私,我们建议你永远放弃Gmail或Facebook等服务。

随着人们对公司如何处理数据和用户隐私的关注与日俱增,越来越多的公司开发出了令人惊叹的注重隐私的替代产品。越来越多的人更进一步,选择去谷歌化,完全停止使用大型科技服务。

幸运的是,在 2026 年,这是可能的!例如,用 Tuta Mail 取代Gmail,或用 Signal 等更好的信使平台取代 Meta 的 WhatsApp。

选择 Tuta,无人工智能,无广告

想确保你的邮件不是用来训练人工智能的吗? 只需转用 Tuta Mail - 作为端到端加密电子邮件和日历提供商,我们不会加入人工智能列车!

Tuta 总部位于德国,根据严格的数据隐私法运营,它是开源的、符合 GDPR 的、完全端到端加密的。

与流行的电子邮件提供商不同,Tuta Mail 采用全球首个后量子加密协议,尽可能多地加密用户数据!Tuta Mail 没有与 Google 的链接,没有广告,不跟踪用户,在设计时充分考虑了隐私问题。

夺回您的隐私,确保您的邮件不会被用于人工智能训练。