Microsoft Copilot aveva accesso alle e-mail riservate delle organizzazioni, senza autorizzazione.

Microsoft ha ammesso che un bug in Microsoft 365 Copilot ha inavvertitamente consentito all'assistente AI di accedere a e-mail riservate.

Secondo Bleeping Computer, un rapporto di servizio sul bug(tracciato come CW1226324), inizialmente rilevato il 21 gennaio, riguarda la funzione di chat Copilot “scheda lavoro”. Questa funzione consente all’intelligenza artificiale di leggere e riassumere le e-mail presenti nelle cartelle inviate e di bozza degli utenti. Cosa ancora più preoccupante, l’intelligenza artificiale ha avuto accesso alla lettura e al riepilogo delle e-mail contrassegnate da etichette di riservatezza, che sono esplicitamente progettate per garantire che gli strumenti automatizzati non abbiano accesso.

Microsoft ha dichiarato di aver confermato il problema a Bleeping Computer:

La chat della ‘scheda lavoro’ di Microsoft 365 Copilot sta riassumendo i messaggi di posta elettronica anche se a questi messaggi è stata applicata un’etichetta di riservatezza ed è stato configurato un criterio DLP”.

Il gigante tecnologico della Silicon Valley ha inoltre dichiarato che “un problema di codice consente agli elementi nelle cartelle degli invii e delle bozze di essere raccolti da Copilot anche se sono state impostate le etichette di riservatezza”. Microsoft ha ora confermato di aver iniziato a distribuire una correzione per il bug all’inizio di febbraio. Mercoledì, Microsoft ha dichiarato che sta monitorando la distribuzione e sta contattando alcuni utenti per confermare che la correzione funziona.

L’uso di Copilot per aumentare la produttività non vale il rischio

Microsoft ha spinto il rollout della sua AI, Copilot, in tutte le app di Microsoft 365, non solo per uso personale, ma anche per le aziende per integrare la forza lavoro. Nel settembre 2025, Copilot Chat, la chat alimentata dall’intelligenza artificiale di Microsoft che consente agli utenti di interagire con agenti AI, è stata introdotta in Excel, Word, Outlook, PowerPoint e OneNote per i clienti business di Microsoft 365. Ora, a distanza di soli quattro mesi, un bug ha compromesso i dati sensibili degli utenti di Microsoft 365.

Mentre l’uso di assistenti AI, come Copilot Chat, viene proposto a livello globale dai giganti tecnologici per aumentare la produttività e velocizzare i flussi di lavoro, ciò che è chiaro è che le nuove tecnologie AI in via di sviluppo possono diventare un rischio estremo per la sicurezza e la privacy, soprattutto per le organizzazioni che devono proteggere le informazioni sensibili.

Aumento dei prezzi, IA e un bug difettoso: Addio riservatezza delle e-mail!

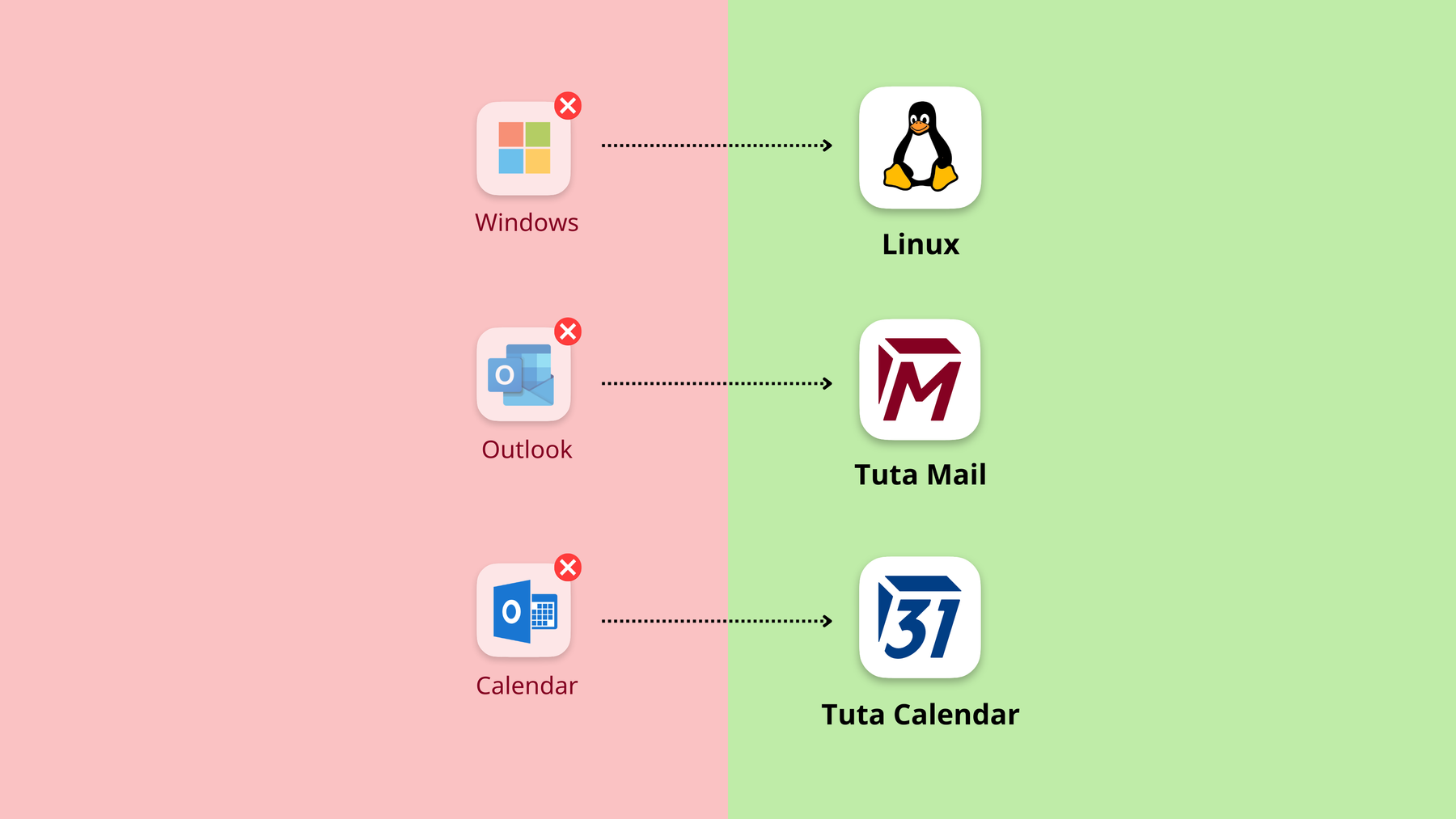

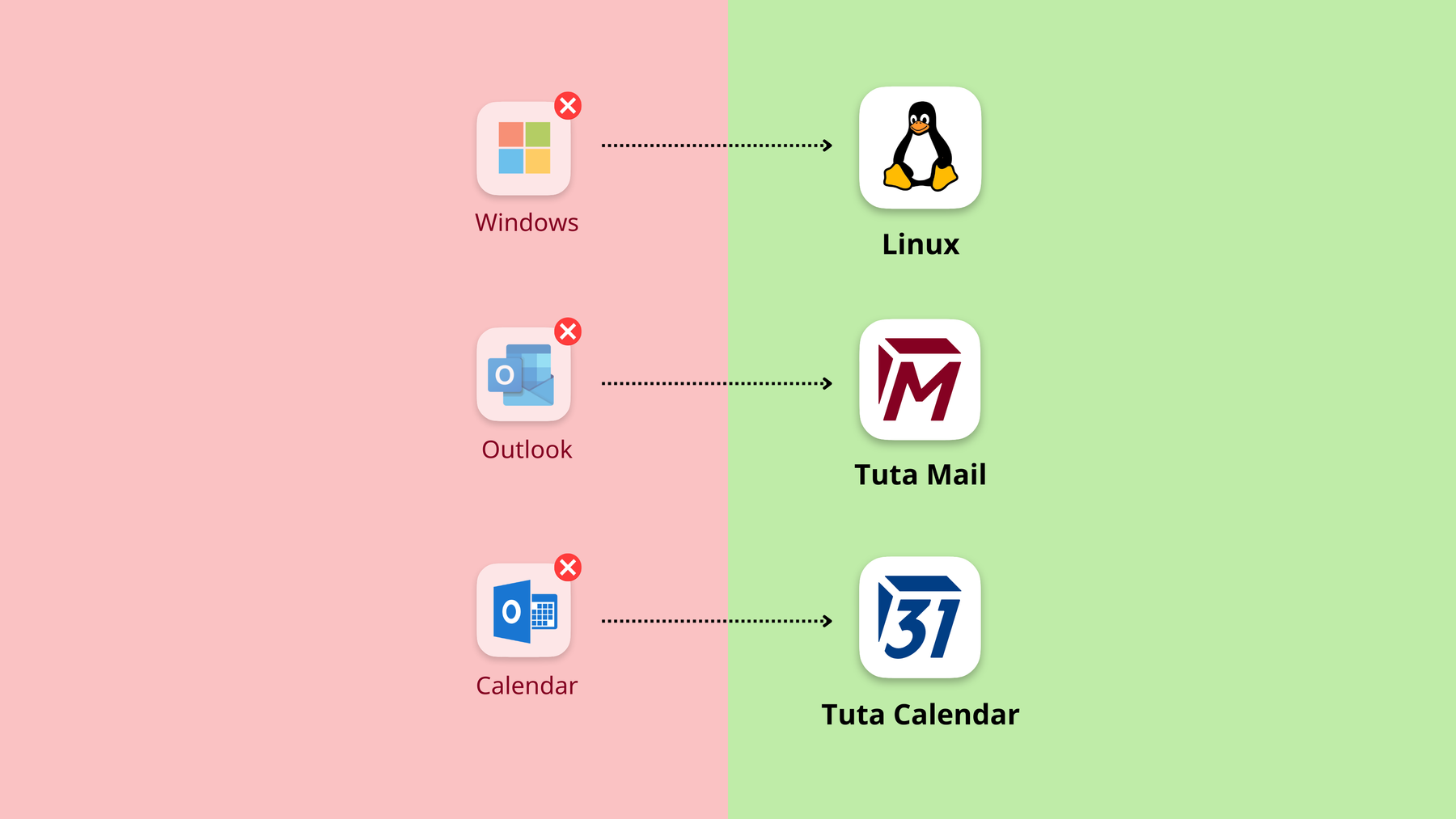

Molte aziende oggi utilizzano Microsoft Outlook, soprattutto perché viene fornito in bundle con gli strumenti Office di Microsoft come Word ed Excel, ma i recenti sviluppi dimostrano che il passaggio ad alternative, in particolare per la posta elettronica, diventa sempre più interessante.

-

Nel gennaio 2026, un bug ha permesso a Copilot Chat di riassumere le e-mail nonostante la configurazione delle etichette di sensibilità e dei criteri DLP.

-

Nel 2025, Microsoft ha annunciato forti aumenti dei prezzi di Microsoft 365 a partire da luglio 2026.

-

Nel settembre 2025, Microsoft ha introdotto Copilot Chat in Excel, Word, Outlook, PowerPoint e OneNote per i clienti aziendali Microsoft 365 paganti.

Una cosa risulta chiara da tutto questo: Se la vostra azienda utilizza Microsoft 365, è ora di abbandonare il vendor lock-in e proteggere le vostre informazioni riservate. Fortunatamente sono disponibili eccellenti alternative ai prodotti Microsoft.

È ora di abbandonare il vendor lock-in

Questo non è il primo né l’ultimo problema di sicurezza che Microsoft ha incontrato.

-

Nel 2024, il governo degli Stati Uniti ha chiesto a Microsoft di applicare una patch alla sicurezza, prima di aggiungere nuove funzionalità, dopo che la Cina aveva violato i server di posta elettronica di Microsoft.

-

Nel 2025, le aziende sono state avvertite di non passare al “Nuovo Outlook” perché non rispetta le leggi sulla protezione dei dati che le aziende devono rispettare.

-

Nel 2025, Microsoft ha innescato la tendenza alla sovranità digitale europea, dopo che l’avvocato di Microsoft in Francia ha confermato che tutti i dati ospitati da Microsoft, anche se conservati nei data center europei, possono essere consultati dal governo degli Stati Uniti - senza preavviso.

Con l’integrazione e il rapido sviluppo di Copilot in Microsoft 365, i dati dei singoli e delle organizzazioni rimarranno a rischio.

L’annuncio di questo bug, a pochi mesi dall’introduzione di Copilot nei piani aziendali di Microsoft 365, evidenzia il motivo per cui gli assistenti AI non appartengono alle e-mail e l’importanza di utilizzare e-mail crittografate Ende-zu-Ende, come Tuta Mail.