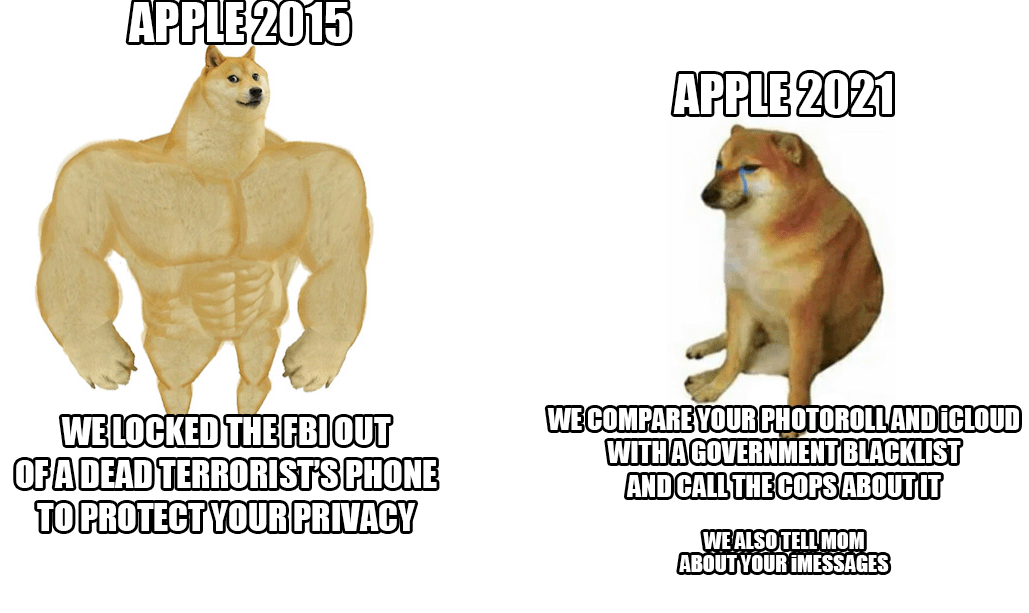

腐烂的苹果:iOS 15,个人隐私,以及正在进行的反CSAM斗争。

“iOS 15 触摸。在这一刻。“

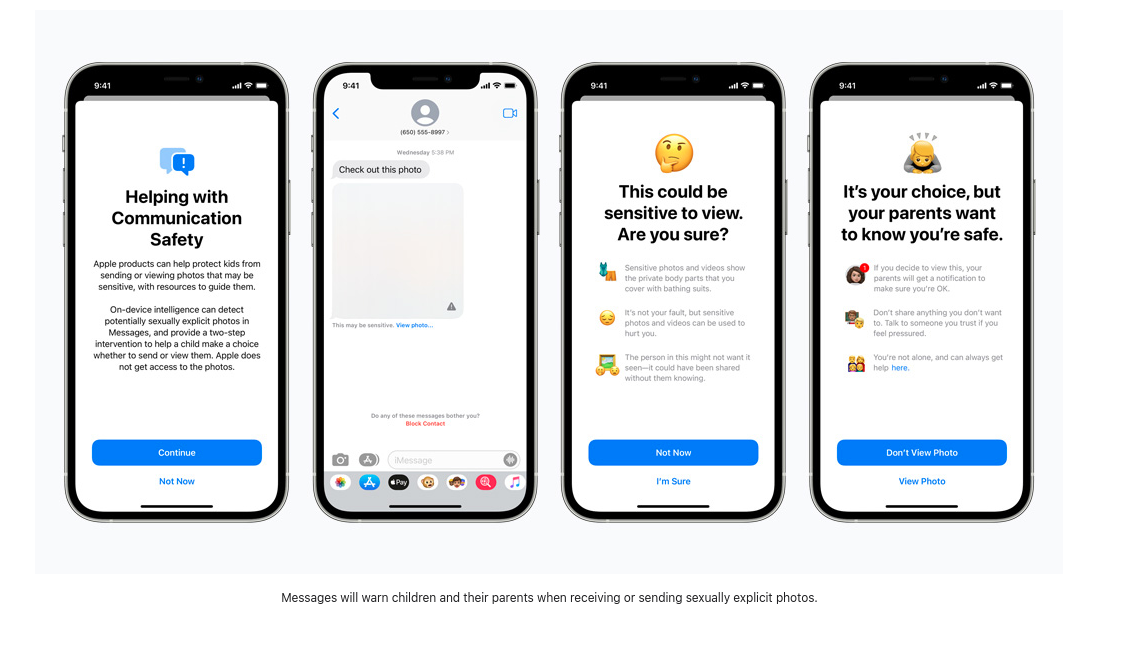

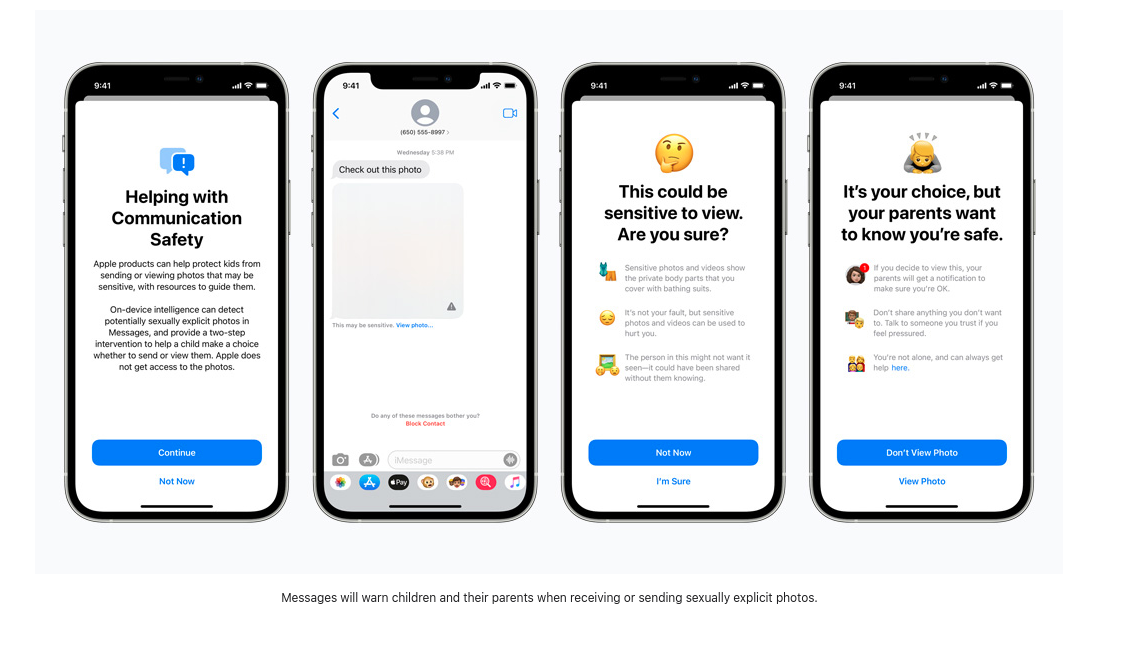

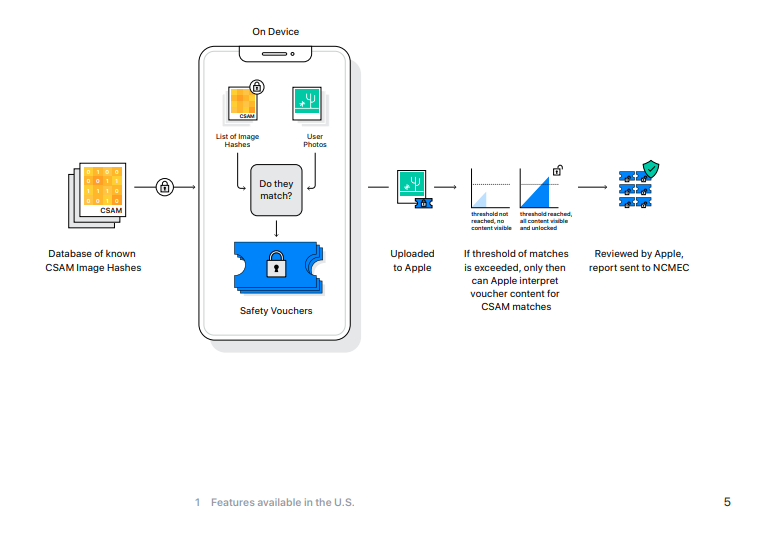

随着这个新的操作系统的更新,我们似乎得到了三个新的功能,根据苹果公司的说法,这些功能将 “帮助保护儿童免受使用通信工具招募和利用他们的掠夺者的侵害,并限制儿童性虐待材料(CSAM)的传播。” 第一个功能旨在改善 “信息中的通信安全”,增加了新的家长控制工具和警告,当发送或接收色情材料时将会出现。第二项功能是使用CSAM检测算法,扫描照片应用中与已知CSAM散列值相匹配的图像散列值。第三个新的儿童保护功能引入了搜索 “指导”,为用户提供报告CSAM的资源,如果用户搜索与CSAM有关的术语,将积极进行干预。让我们花点时间,解读一下这些功能的目的以及它们如何做到的细节。

不再有不请自来的阴茎照片。

Thorn最近的一项研究报告称,“自我生成的儿童性虐待材料(SG-CSAM)是一个快速增长的儿童性虐待材料(CSAM)领域,在网上流通,并被虐待者社区所消费。” 苹果新的 “扩大的儿童保护 “旨在减缓这种做法的增长。浪漫伴侣之间的 “裸体 “分享往往在同龄人群体中传播,并可能在 “报复性色情 “的情况下最终出现在网上。苹果公司现在将开始向儿童(或启用这些安全功能的用户)提出关于查看或发送露骨图像的警告。如果有图像被观看或发送,父母的设备将收到有关该活动的通知信息。

传入的图像会被一个设备上的机器学习程序扫描,该程序标记出可疑材料,并 “学习 “确定未来的图像是否属于同一类别。谁控制这个算法,以及用户能对它如何报告可疑图像产生什么影响,这些都没有披露。苹果公司写道,这一 “功能的设计使苹果公司无法获得信息。“因此,随着这一新的更新,苹果公司将开始筛选通过iMessage发送的加密信息,以警告父母和青少年的有害在线行为。

从表面上看,这可能并不危险,但如果采用同样的扫描技术来扫描加密信息中的不同政治观点、少数宗教语言或对性取向的讨论,这种新的设备上的监控软件可能很容易被改变和滥用。

扫描以阻止传播。

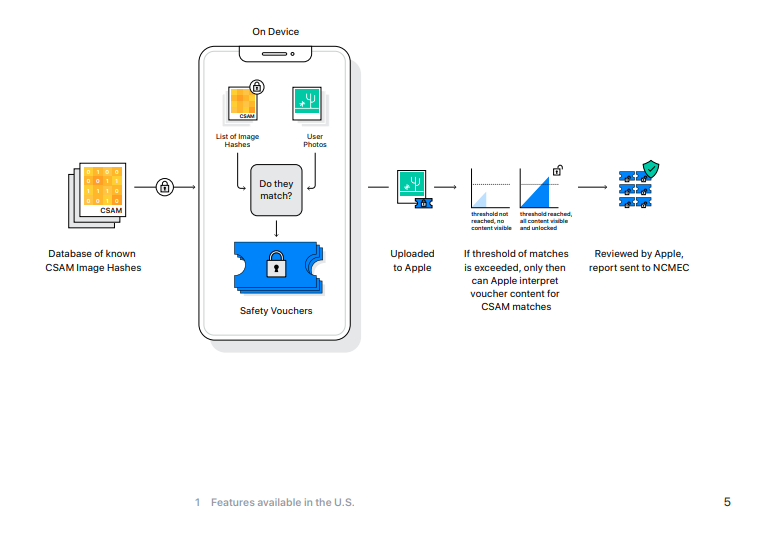

根据电子前沿基金会的说法,“尽管苹果掌握着查看存储在iCloud照片的钥匙,但它并不扫描这些图像。” 这将在iOS 15中发生变化,如果你目前在苹果的iCloud中备份照片,这些照片将被散列,这些值将与已知的CSAM的值进行比较。

如果iOS设备已启用iCloud备份功能,这种扫描将首先在本地机器上开始。新的iOS 15包括国家失踪与被剥削儿童中心的CSAM散列图像数据库的一个版本,在iPhone上拍摄的非加密图像将被用来与NCMEC的数据库中的散列值(希望是代表图像的唯一数字值)进行比较。如果出现匹配,照片会被送到苹果公司的人工审查员那里。如果这些审查人员能够确认匹配,那么该图像将被发送到NCMEC、执法部门,然后用户的账户将被停用。

如果你使用iCloud备份你的照片,你的照片将根据这个数据库进行扫描,没有可能的理由或怀疑你可能犯下或参与了任何犯罪。

[不要]看这张照片。

最后一项新的儿童安全功能是对Siri和搜索的更新,它将提供关于如何报告CSAM案件的指导,以及在用户搜索与CSAM有关的术语时进行 “干预”。

确切的词表没有公开,我们不知道用户报告的术语是否会被用来训练机器学习的搜索监控。

关于什么样的词会触发这些警告,以及当这些警告被忽略时会发生什么,目前的信息非常少。在图像散列审查的情况下,苹果员工将确定匹配结果,但我们不知道对搜索结果采取什么进一步措施。在查看苹果官方关于这些新功能的新闻页面时,关于受监控的搜索词的讨论只有简短的四句话。看看这个列表是否会根据用户报告的术语或苹果选择如何训练这个算法而增长,这也将是很有趣的。

如果你没有什么可隐藏的…

在这三个新功能之间,苹果用户和那些与他们一起发送信息和图片的人,正在受到他们的加密信息的扫描,监测他们的私人搜索词,而所有这些都是在没有任何犯罪嫌疑或证据的情况下发生的。苹果公司和其他大型科技公司扫描存储在其服务器上的图像的哈希值是一回事。毕竟,这些服务器是公司的财产,你没有必要使用它们。但把这些新的监控功能推到本地设备上,却忽略了一个事实,即你,设备的所有者,已经为一个监控你行为的设备支付了数百美元(或欧元)。对于什么程序在运行你的个人财产,你没有太多的选择。这种 “改进 “更加偏向于产品即服务的模式,这种模式已经成为专有软件世界的主流。

有了这个新版本的iOS,苹果正在破坏他们曾经被称赞的信息平台的安全性。一个端到端加密的消息应用,一旦到达目的地设备就会扫描图像,这是一个危险的谎言,对保护苹果用户的安全和隐私毫无帮助。这种行为如何被不尊重人权的民族国家应用,是一种灾难的根源。

IOS 15为未来的端到端加密设定了一个危险的标准。

保护儿童将成为引领我们进入一个监视增加和个人隐私解体的世界的口号。是的,CSAM是可恶的,应该在法律允许的范围内被起诉,但CSAM的存在并不意味着放弃围绕隐私、数据加密、性暴力和监控的细微讨论。

马修-格林对这些变化的后果提出警告,他写道:“不管苹果的长期计划是什么,他们已经发出了一个非常明确的信号。在他们(非常有影响力的)看来,建立扫描用户手机的禁止内容的系统是安全的。这就是他们向政府、竞争服务机构、中国、你发出的信息。”