CSAM Scanning: Mentiras da Comissão da UE descobertas - A vigilância não salvará as crianças.

Analisámos as ordens de vigilância das telecomunicações. Os dados mostram que o scanning CSAM da UE é completamente desproporcionado e deve ser interrompido.

No seu projecto de lei para combater o abuso sexual de crianças, a Comissão da UE descreve um dos mais sofisticados aparelhos de vigilância em massa jamais implantados fora da China: Scanner CSAM nos aparelhos de toda a gente. Como serviço de correio electrónico, recebemos regularmente ordens de monitorização das autoridades alemãs. Analisámos estes dados para saber se são emitidas ordens de monitorização para perseguir os pedófilos.

Digitalização CSAM

O projecto de regulamento da Comissão Europeia sobre a prevenção e combate ao abuso de crianças é um ataque frontal aos direitos civis. E a Comissão da UE está a pressionar para que este projecto se torne lei com exageros maciços.

Como cidadãos, podemos esperar mais da Comissão da UE. O mínimo que podemos pedir quando a Comissão quiser introduzir mecanismos de vigilância que enfraqueçam imensamente a ciber-segurança da Europa seria uma comunicação honesta.

Ninguém nega que o abuso sexual de crianças é uma grande questão que precisa de ser abordada. Mas quando se propõem medidas tão drásticas como o scanning CSAM de cada mensagem de conversa privada, os argumentos devem ser sólidos. Caso contrário, a Comissão da UE não está a ajudar ninguém - nem as crianças, nem as nossas sociedades livres e democráticas.

A Comissão da UE conseguiu empurrar três argumentos para o debate público a fim de fazer a opinião pública balançar a favor da digitalização de material CSA em cada dispositivo. Mas os argumentos estão descaradamente errados:

- Um em cada cinco: A Comissão da UE afirma que uma em cada cinco crianças na UE seria abusada sexualmente.

- A vigilância baseada na IA não prejudicaria o nosso direito à privacidade, mas salvaria as crianças.

- 90 % da CSAM seria alojada em servidores europeus

A Comissão da UE utiliza a alegação “Um em Cinco” para justificar a proposta de vigilância geral de massa de todos os cidadãos europeus.

Sim, o abuso de crianças é um problema imenso. Todos os peritos na área da protecção de crianças concordarão que a política precisa de fazer mais para proteger os mais vulneráveis da nossa sociedade: as crianças.

No entanto, a questão da proporção deve ser examinada muito atentamente quando se trata da vigilância CSAM nos nossos dispositivos pessoais: Será correcto que a UE introduza mecanismos de vigilância em massa para todos os cidadãos da UE, numa tentativa de combater o abuso sexual de crianças?

A associação alemã “Digitale Gesellschaft” publicou um vídeo que pretende responder também à questão da proporcionalidade; vale a pena assistir!

Para encontrar uma resposta à questão da proporcionalidade, precisamos de apagar a propaganda da Comissão da UE e, em vez disso, fazer várias perguntas:

1. Uma em cinco

De onde vem o número ‘Um em Cinco’?

Não há estatísticas que sustentem a alegação ‘Um em Cinco’. Este número é colocado de forma proeminente num website pelo Conselho da Europa, mas sem dar qualquer fonte.

De acordo com a Organização Mundial de Saúde (OMS), 9,6% das crianças em todo o mundo são abusadas sexualmente. Ao contrário dos números da UE, estes dados baseiam-se num estudo, uma análise dos inquéritos comunitários.

No entanto, ignoremos o exagero da Comissão Europeia relativamente às crianças afectadas, uma vez que o número publicado pela OMS ainda é muito elevado e deve ser abordado.

O número publicado pela OMS sugere que mais de 6 milhões de crianças na UE sofrem de abuso sexual.

Consequentemente, podemos concordar que a UE deve fazer algo para acabar com o abuso sexual de crianças.

2. Pode a vigilância ajudar a combater o abuso sexual de crianças?

Onde se verifica o abuso?

Outra questão muito importante ao introduzir medidas de vigilância para combater o abuso sexual de crianças é a da eficácia.

Se a vigilância da nossa comunicação privada (CSAM scanning) ajudasse a salvar milhões de crianças na Europa do abuso sexual, muitas pessoas concordariam com a medida. Mas será que isso seria realmente o caso?

No mesmo website que a Comissão da UE afirma que “1 em cada 5” crianças são afectadas, também dizem que “entre 70% a 85% das crianças conhecem o seu agressor. A grande maioria das crianças são vítimas de pessoas em quem confiam”.

Isto suscita a questão: Como é que o rastreio de CSAM em cada mensagem de chat vai ajudar a prevenir o abuso sexual de crianças dentro da família, no clube desportivo ou na igreja?

A Comissão da UE deixa esta pergunta sem resposta.

Quantas ordens de controlo são sobre a protecção das crianças?

Para saber se a monitorização de mensagens privadas para material CSA pode ajudar a combater o abuso sexual de crianças, temos de analisar os dados de monitorização reais que já estão disponíveis.

Como fornecedor de correio electrónico com sede na Alemanha, dispomos de tais dados. O nosso relatório de transparência mostra que recebemos regularmente ordens de vigilância de telecomunicações das autoridades alemãs para perseguir potenciais criminosos.

Poder-se-ia pensar que Tutanota como um serviço de correio electrónico codificado de ponta a ponta, centrado na privacidade, seria o lugar de passagem para os criminosos, por exemplo, para partilhar CSAM.

Em consequência, seria de esperar que o número de ordens judiciais emitidas em relação à “pornografia infantil” fosse elevado.

Em 2021 recebemos UMA ordem de vigilância de telecomunicações com base na suspeita de que a conta foi utilizada no que diz respeito à “pornografia infantil”.

Isto representa 1,3% de todas as ordens que recebemos em 2021. Mais de dois terços das encomendas foram emitidas em relação a “resgates”; alguns casos individuais em relação à violação de direitos de autor, preparação de crimes graves, chantagem e terror.

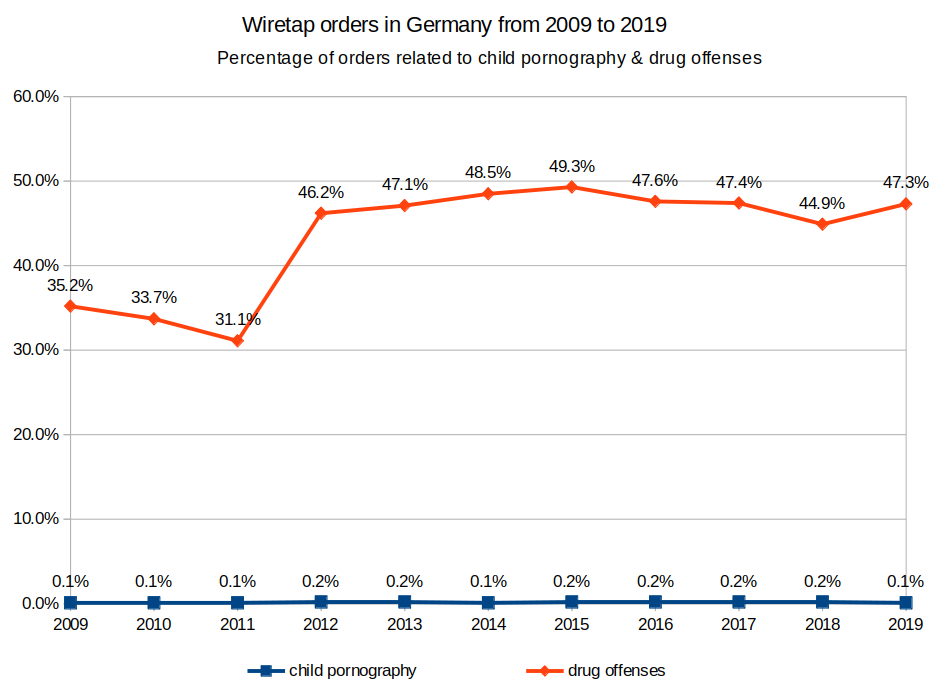

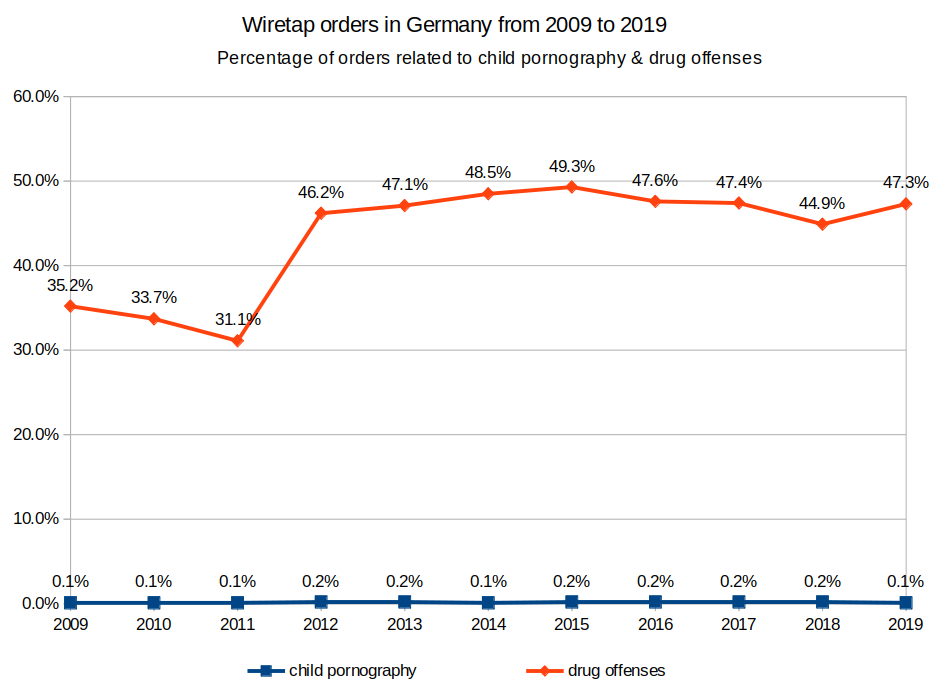

Números publicados pelo Gabinete Federal de Justiça alemão pintam um quadro semelhante: Na Alemanha, mais de 47,3 por cento das medidas de vigilância das telecomunicações de acordo com o § 100a StPO foram ordenadas para encontrar suspeitos de infracções relacionadas com drogas em 2019. Apenas 0,1 por cento das ordens - ou 21(!) no total - foram emitidas em relação à “pornografia infantil”.

Em 2019, houve 13.670 casos de abuso de crianças de acordo com asestatísticas do Ministério Federal Alemão do Interior na Alemanha.

Se considerarmos estes números em conjunto, houve 13.670 casos de abuso de crianças na Alemanha em 2019. Em apenas 21 destes casos, foi emitida uma ordem de vigilância de telecomunicações.

Torna-se óbvio que a vigilância das telecomunicações (que já é possível) não desempenha um papel significativo na localização dos perpetradores.

A conclusão aqui é óbvia: “Mais vigilância” não trará “mais segurança” às crianças na Europa.

3. Europa - um centro para a CSAM?

À semelhança da alegação “Um em Cinco”, a Comissão Europeia afirma que 90% do material sobre abuso sexual de crianças está alojado em servidores europeus. Mais uma vez, a Comissão da UE utiliza esta alegação para justificar o seu scan CSAM planeado.

No entanto, mesmo os peritos neste campo, a Associação ecológica alemã que trabalha em conjunto com as autoridades para derrubar o CSAM (Child Sexual Abuse Material), afirmam que “na sua estimativa, os números estão muito longe dos 90 por cento alegados”. Alexandra Koch-Skiba, da Associação ecológica, tambémafirma: “Na nossa opinião, o projecto tem o potencial de criar um passe livre para a vigilância governamental. Isto é ineficaz e ilegal. A protecção sustentável de crianças e jovens exigiria, em vez disso, mais pessoal para investigações e processos judiciais abrangentes”.

Até mesmo os agentes da lei alemães estão acriticar os planos da UE à porta fechada. Argumentam que haveria outras formas de localizar mais infractores: “Se se trata apenas de ter mais casos e apanhar mais perpetradores, então não é necessária tal intromissão nos direitos fundamentais”, diz outro investigador de longa data sobre abuso de crianças.

Exagero à beira de notícias falsas

É inacreditável que a Comissão da UE utilize estes exageros para convencer a opinião pública a favor da digitalização CSAM. Parece que o argumento “para proteger as crianças” é utilizado para introduzir mecanismos de vigilância semelhantes aos chineses. Aqui na Europa.

Mas a Europa não é a China.

O que é que posso fazer?

Na Alemanha, há pelo menos uma centelha de esperança. Um documento de “controlo de conversa” divulgado sugere que o actual governo alemão irá opor-se à proposta da Comissão Europeia.

Agora nós, como cidadãos da Europa e membros da sociedade civil, devemos pressionar os legisladores para que se oponham à legislação que irá colocar cada e-mail e cada mensagem de chat que enviarmos sob vigilância constante.

E pode fazer muito para nos ajudar a lutar pela privacidade

-

- Partilhe este post no blogue para que todos compreendam as falsas alegações feitas pela Comissão da UE.

-

- Partilhe o vídeo da ‘Digitale Gesellschaft’ para que todos compreendam que este texto legislativo é completamente desproporcionado e que existem formas muito melhores de proteger as crianças.

-

- Ligue/ envie um e-mail ao seu representante da UE para fazer ouvir a sua voz: Pare a digitalização CSAM no meu dispositivo pessoal!

O que significa a CSAM?

CSAM refere-se ao Material de Abuso Sexual de Crianças, imagens que retratam o abuso e exploração sexual de crianças.

Quem efectua scans de CSAM?

Vários serviços efectuam scans de material CSAM nos seus servidores, por exemplo oGoogle. Desde 6 de Julho de 2021, as empresas da UE podem também fazer scans voluntários de material CSA.

Quais são as consequências da digitalização de material CSAM?

A digitalização de material CSA pelo lado do cliente transformará os seus próprios dispositivos em máquinas de vigilância. Se a digitalização CSAM se tornar obrigatória, todas as mensagens de chat e todos os e-mails que enviar serão digitalizados e lidos por outros. A digitalização do lado do cliente, portanto, mina o seu direito à privacidade.