Pommes pourries : iOS 15, la vie privée et la lutte permanente contre les MSC.

“iOS 15 En contact. In the moment.”

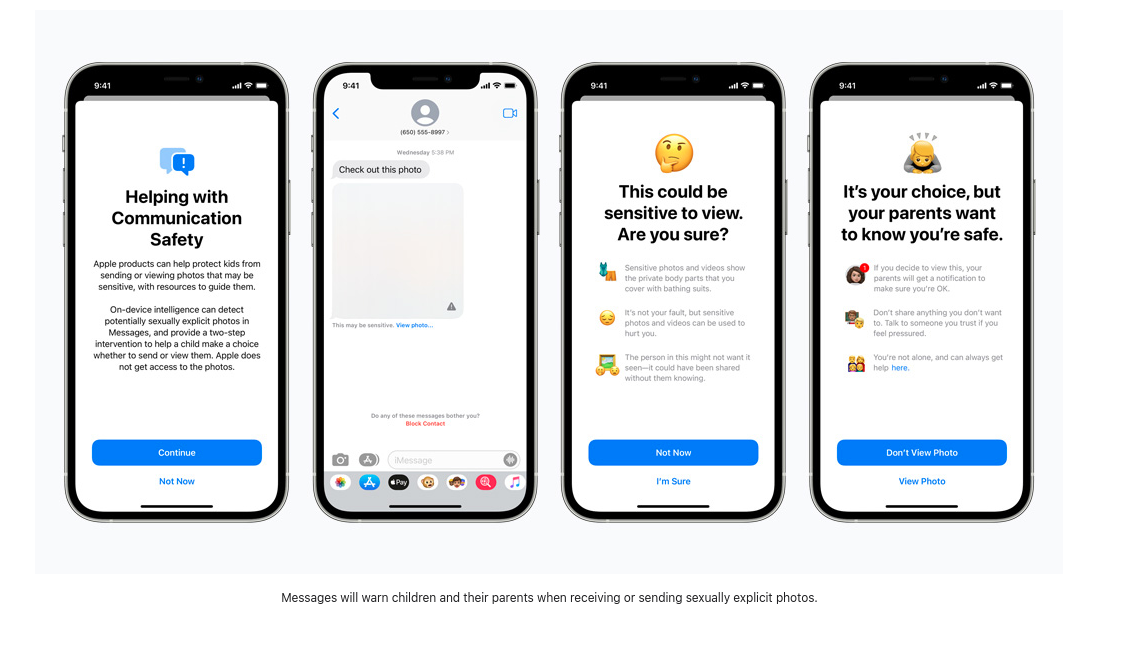

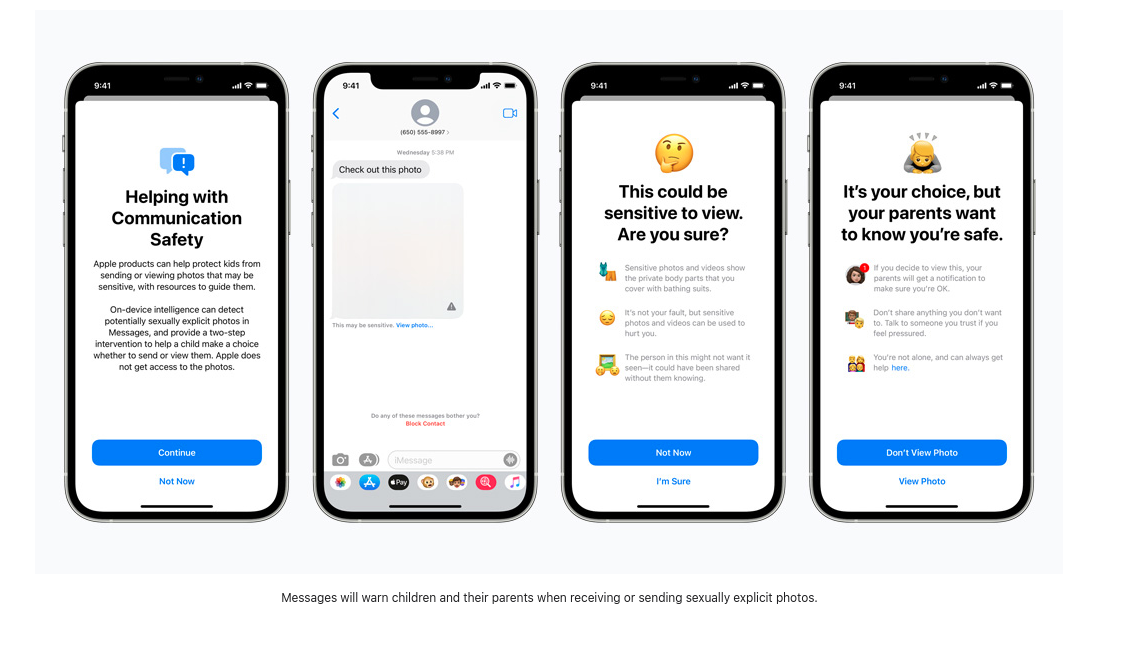

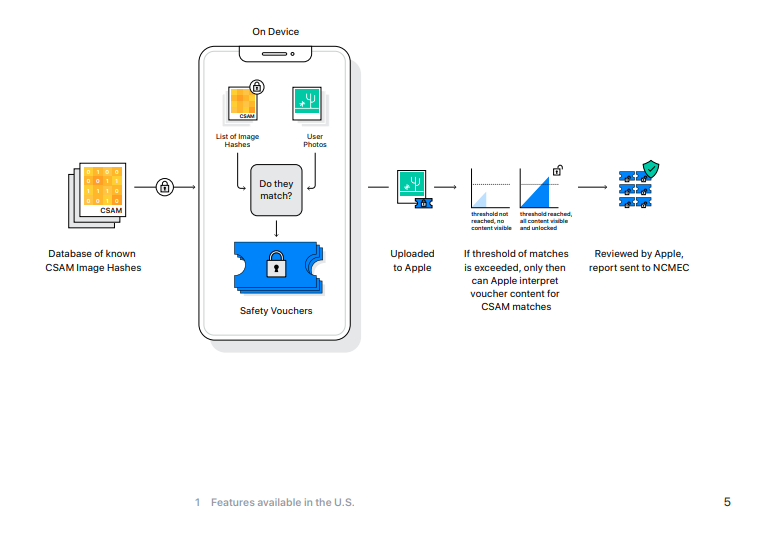

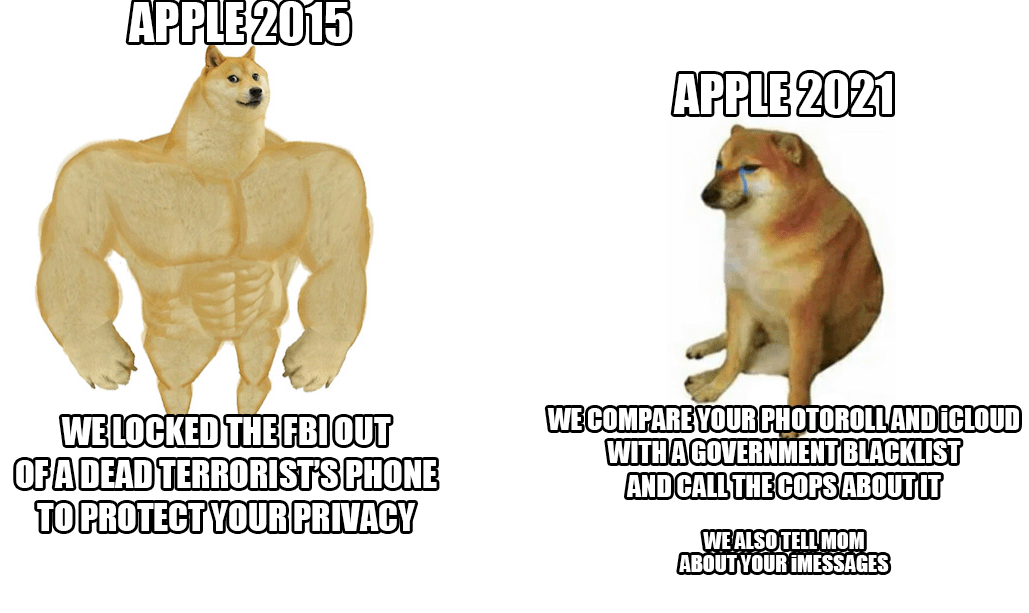

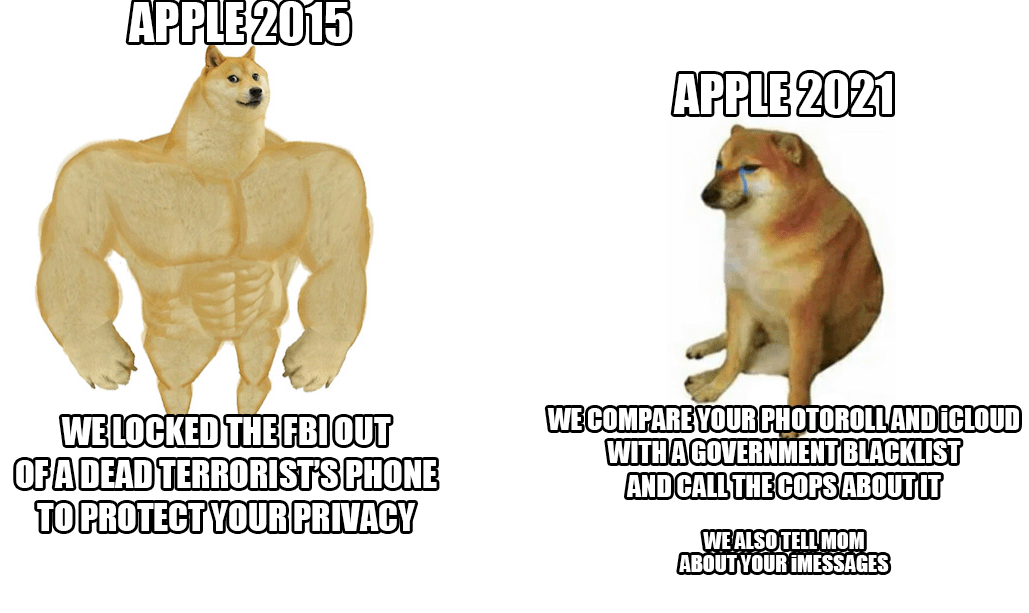

Avec cette nouvelle mise à jour du système d’exploitation, il semble que nous recevions trois nouvelles fonctionnalités qui, selon Apple, vont “aider à protéger les enfants contre les prédateurs qui utilisent les outils de communication pour les recruter et les exploiter, et limiter la diffusion de matériel pédopornographique (CSAM)” La première vise à améliorer la “sécurité de la communication dans Messages” qui ajoute de nouveaux outils de contrôle parental et des avertissements qui apparaîtront lorsque du matériel sexuellement explicite est envoyé ou reçu. La deuxième est une fonctionnalité qui utilisera un algorithme de détection de CSAM pour analyser l’application Photos à la recherche de hachages d’images qui correspondent à des hachages CSAM connus. La troisième nouvelle fonctionnalité de protection de l’enfance introduit des “conseils” de recherche qui fournissent aux utilisateurs des ressources pour signaler le CSAM et qui interviendront activement si les utilisateurs recherchent un terme lié au CSAM. Prenons un moment pour expliquer en détail ce que ces fonctionnalités visent à faire et comment elles le font.

Plus de photos de bites non sollicitées.

Selon une étude récente de Thorn, “le matériel pédopornographique auto-généré (SG-CSAM) est un domaine en pleine expansion du matériel pédopornographique (CSAM) en circulation en ligne et consommé par des communautés d’abuseurs”, et la nouvelle fonction “Expanded Protections for Children” d’Apple vise à ralentir la croissance de cette pratique. Le partage de “nus” entre partenaires romantiques se répand souvent dans un groupe de pairs et peut se retrouver en ligne dans des cas de “revenge porn”. Apple commencera désormais à présenter aux enfants (ou aux utilisateurs dont les fonctions de sécurité sont activées) des avertissements concernant la visualisation ou l’envoi d’images explicites. En cas de visualisation ou d’envoi d’une image, l’appareil du parent recevra un message de notification concernant cette activité.

Les images reçues sont analysées par un programme d’apprentissage automatique intégré à l’appareil, qui signale les contenus suspects et “apprend” à déterminer si les images suivantes entrent dans la même catégorie. L’identité de la personne qui contrôle cet algorithme et l’influence que les utilisateurs peuvent avoir sur la façon dont il signale les images suspectes n’ont pas été révélées. Apple écrit que cette “fonctionnalité est conçue de manière à ce qu’Apple n’ait pas accès aux messages”. Ainsi, avec cette nouvelle mise à jour, Apple commencera à examiner les messages cryptés envoyés via iMessage afin d’avertir les parents et les adolescents des comportements en ligne dangereux.

À première vue, cela ne semble pas dangereux, mais si cette même technologie d’analyse était utilisée pour analyser les messages cryptés à la recherche d’opinions politiques dissidentes, de langues religieuses minoritaires ou de discussions sur l’orientation sexuelle, ce nouveau logiciel de surveillance sur l’appareil pourrait être facilement modifié et utilisé à mauvais escient.

Scanner pour arrêter la propagation.

Selon l’Electronic Frontier Foundation, “bien qu’Apple détienne les clés pour visualiser les photos stockées dans iCloud Photos, elle ne scanne pas ces images”, ce qui changera avec iOS 15 et si vous sauvegardez actuellement vos photos dans iCloud d’Apple, ces photos seront hachées et ces valeurs seront comparées à celles de MSC connus.

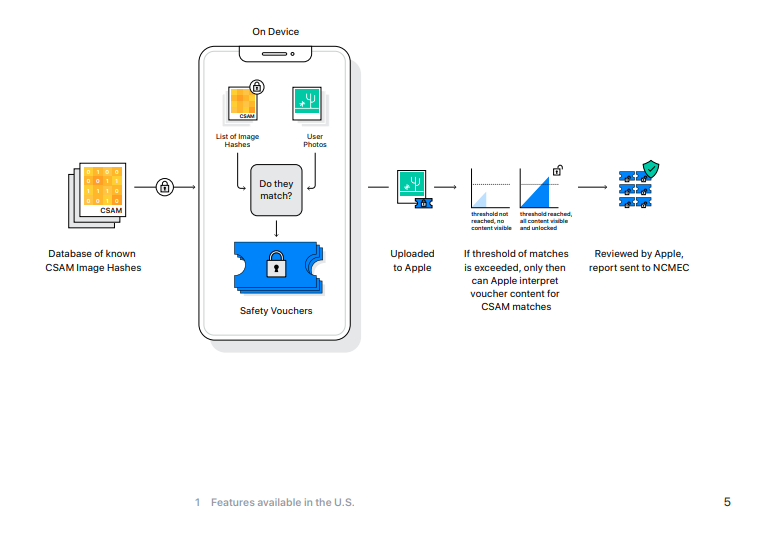

Si un appareil iOS a activé la fonction de sauvegarde iCloud, cette analyse commencera d’abord sur la machine locale. Le nouvel iOS 15 comprend une version de la base de données d’images hachées CSAM du National Center for Missing and Exploited Children (NCMEC), et les images non cryptées prises sur un iPhone verront leurs hashs (une valeur numérique *espérons-le * unique représentant l’image) comparés à ceux de la base de données du NCMEC. En cas de correspondance, les photos sont envoyées à des examinateurs humains chez Apple. Si ces examinateurs peuvent confirmer la correspondance, l’image est alors envoyée au NCMEC, aux forces de l’ordre, et le compte de l’utilisateur est alors désactivé.

Si vous utilisez iCloud pour sauvegarder vos photos, celles-ci seront comparées à cette base de données, sans cause probable ni soupçon que vous ayez pu commettre ou être impliqué dans un quelconque crime.

[Ne regardez pas cette photo.

La dernière nouveauté en matière de sécurité des enfants est une mise à jour de Siri et de la fonction de recherche qui fournira des conseils sur la manière de signaler les cas d’agressions sexuelles commises contre des enfants ainsi que d‘“intervenir” si les utilisateurs recherchent des termes liés à ces agressions.

La liste de mots exacte n’est pas publique et nous ne savons pas si les termes signalés par les utilisateurs seront utilisés pour former le moniteur de recherche à apprentissage automatique.

Il y a très peu d’informations disponibles sur le type de termes qui déclencheront ces avertissements et sur ce qui se passe lorsqu’ils sont ignorés. Dans le cas de la révision du hachage des images, un employé d’Apple déterminera les résultats correspondants, mais nous ne savons pas quelles autres mesures sont prises avec les résultats de recherche. Lorsque l’on consulte la page de presse officielle d’Apple concernant ces nouvelles fonctionnalités, la discussion sur les termes de recherche contrôlés se résume à quatre brèves phrases. Il sera également intéressant de voir si cette liste s’allonge en fonction des termes signalés par les utilisateurs ou de la manière dont Apple choisit d’entraîner cet algorithme.

Si vous n’avez rien à cacher…

Entre ces trois nouvelles fonctionnalités, les utilisateurs d’Apple et ceux qui envoient des messages et des photos avec eux, sont soumis au balayage de leurs messages cryptés, à la surveillance de leurs termes de recherche privés, et tout cela se produit sans aucun soupçon ou preuve d’un crime. C’est une chose pour Apple et d’autres grandes entreprises technologiques de scanner les hachages des images stockées sur leurs serveurs. Après tout, ces serveurs sont la propriété de l’entreprise et vous n’êtes pas obligé de les utiliser. Mais le fait de pousser ces nouvelles fonctions de surveillance sur des appareils locaux ne tient pas compte du fait que vous, le propriétaire de l’appareil, avez payé des centaines de dollars (ou d’euros) pour un appareil qui surveille votre comportement. Vous n’avez pas vraiment le choix quant aux processus qui font fonctionner une partie de votre propriété personnelle. Cette “amélioration” s’éloigne encore plus du modèle “produit en tant que service” qui est déjà devenu courant dans le monde des logiciels propriétaires.

Avec cette nouvelle version d’iOS, Apple met à mal la sécurité de sa plateforme de messagerie, autrefois encensée. Une application de messagerie cryptée de bout en bout qui scanne les images une fois qu’elles ont atteint l’appareil de destination est un mensonge dangereux qui ne fait rien pour protéger la sécurité et la vie privée des utilisateurs d’Apple. La façon dont ce comportement peut être appliqué par des États-nations qui ne respectent pas les droits de l’homme est une recette pour le désastre.

IOS 15 établit une norme dangereuse pour l’avenir du cryptage de bout en bout.

Protéger les enfants sera le mantra qui nous mènera dans un monde de surveillance accrue et de dissolution de la vie privée. Oui, CSAM est odieux et devrait être poursuivi dans toute la mesure de la loi, mais l’existence de CSAM ne justifie pas l’abandon d’une discussion nuancée sur la vie privée, le cryptage des données, la violence sexuelle et la surveillance.

Matthew Green met en garde contre les conséquences de ces changements : “Quels que soient les plans à long terme d’Apple, la société a envoyé un signal très clair. Selon leur opinion (très influente), il est sûr de construire des systèmes qui scannent les téléphones des utilisateurs à la recherche de contenus interdits. C’est le message qu’ils envoient aux gouvernements, aux services concurrents, à la Chine, à vous.”