Manzanas podridas: iOS 15, la privacidad personal y la lucha continua contra el CSAM.

“iOS 15 En contacto. En el momento”.

Con esta nueva actualización del sistema operativo parece que recibiremos tres nuevas funciones que, según Apple, “ayudarán a proteger a los niños de los depredadores que utilizan las herramientas de comunicación para reclutarlos y explotarlos, y limitarán la difusión de Material de Abuso Sexual Infantil (CSAM)” La primera tiene como objetivo mejorar la “Seguridad de la comunicación en Mensajes”, que añade nuevas herramientas de control parental y avisos que aparecerán cuando se envíe o reciba material sexualmente explícito. La segunda es una función que utilizará un algoritmo de detección de CSAM para escanear la aplicación Fotos en busca de hashes de imágenes que coincidan con hashes de CSAM conocidos. La tercera función de protección de la infancia introduce una “guía” de búsqueda que proporciona a los usuarios recursos para denunciar el CSAM e interviene activamente si los usuarios buscan un término relacionado con el CSAM. Dediquemos un momento a desgranar los detalles de lo que estas funciones pretenden hacer y cómo lo hacen.

Se acabaron las fotos de penes no solicitadas.

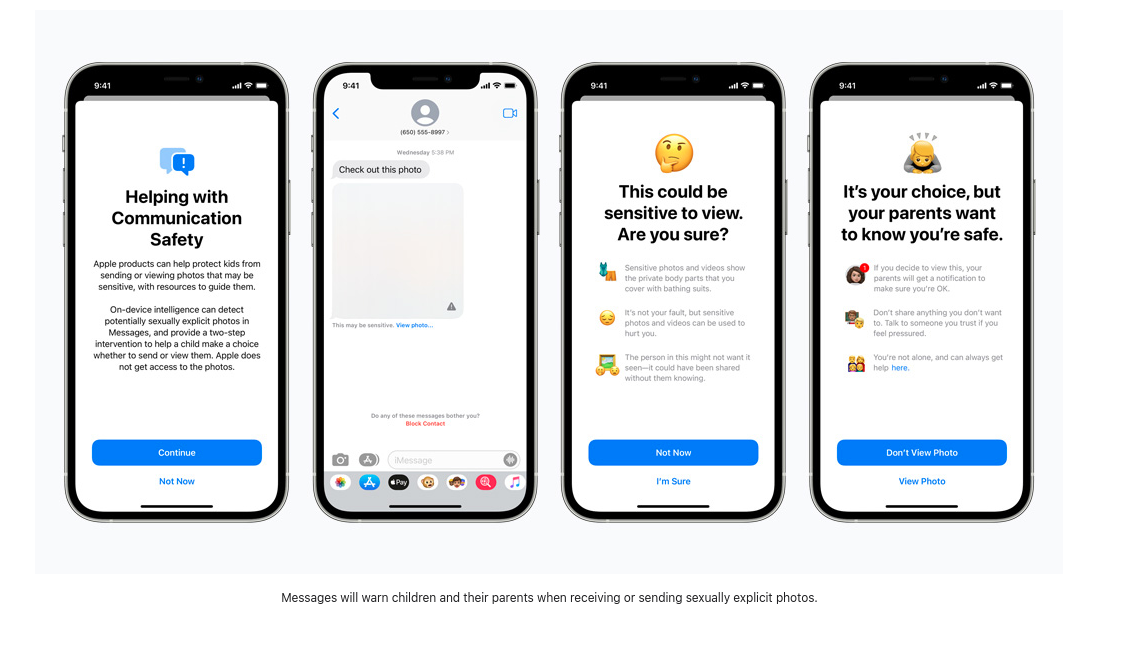

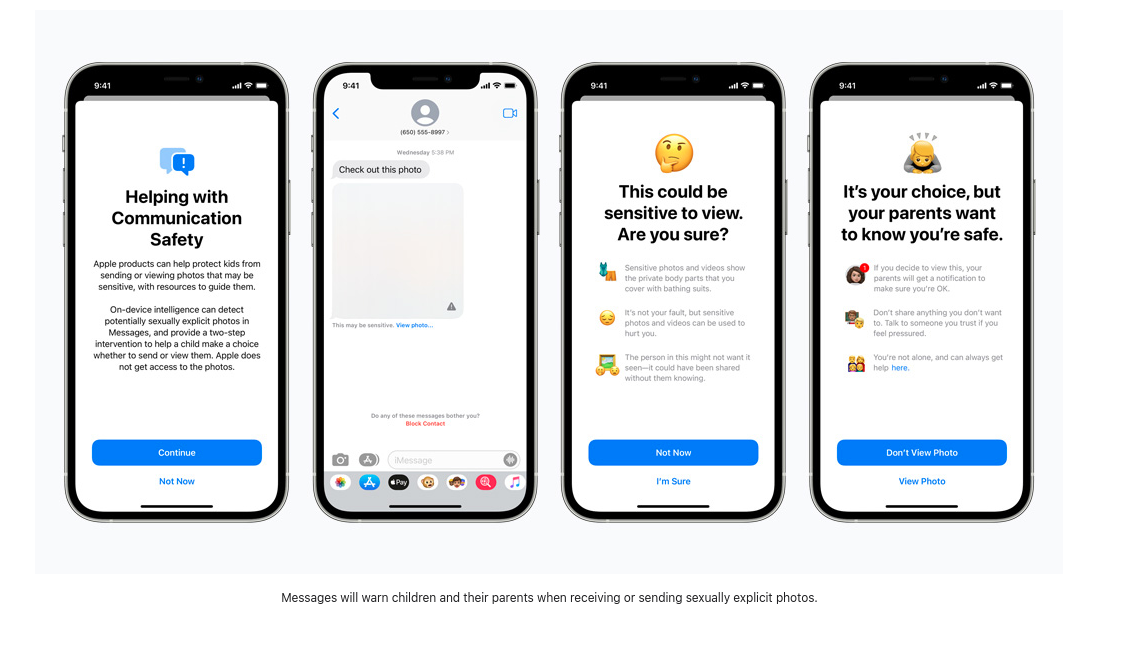

Un estudio reciente de Thorn informa de que “el material de abuso sexual infantil autogenerado (SG-CSAM) es un área de rápido crecimiento de material de abuso sexual infantil (CSAM) en circulación en línea y consumido por las comunidades de abusadores” La nueva “Protección ampliada para los niños” de Apple pretende frenar el crecimiento de esta práctica. El intercambio de “desnudos” entre parejas románticas suele extenderse por un grupo de compañeros y puede acabar en línea en casos de “porno de venganza”. A partir de ahora, Apple empezará a presentar a los niños (o a los usuarios con estas funciones de seguridad activadas) advertencias sobre la visualización o el envío de imágenes explícitas. En caso de que se vea o envíe una imagen, el dispositivo de los padres recibirá un mensaje de notificación sobre la actividad.

Las imágenes entrantes son analizadas por un programa de aprendizaje automático en el dispositivo que marca el material sospechoso y “aprende” a determinar si las futuras imágenes entran en la misma categoría. Quién controla este algoritmo y qué impacto pueden tener los usuarios para influir en la forma en que informa de las imágenes sospechosas sigue sin revelarse. Apple escribe que esta “función está diseñada para que Apple no tenga acceso a los mensajes”, por lo que con esta nueva actualización, Apple comenzará a examinar los mensajes cifrados que se envían a través de iMessage con el fin de advertir a los padres y a los adolescentes sobre el comportamiento perjudicial en línea.

A primera vista, esto puede no parecer peligroso, pero si esta misma tecnología de escaneo se empleara para escanear los mensajes encriptados en busca de opiniones políticas disidentes, lenguas religiosas minoritarias o discusiones sobre la orientación sexual, este nuevo software de monitoreo en el dispositivo podría ser fácilmente alterado y abusado.

Escaneo para detener la propagación.

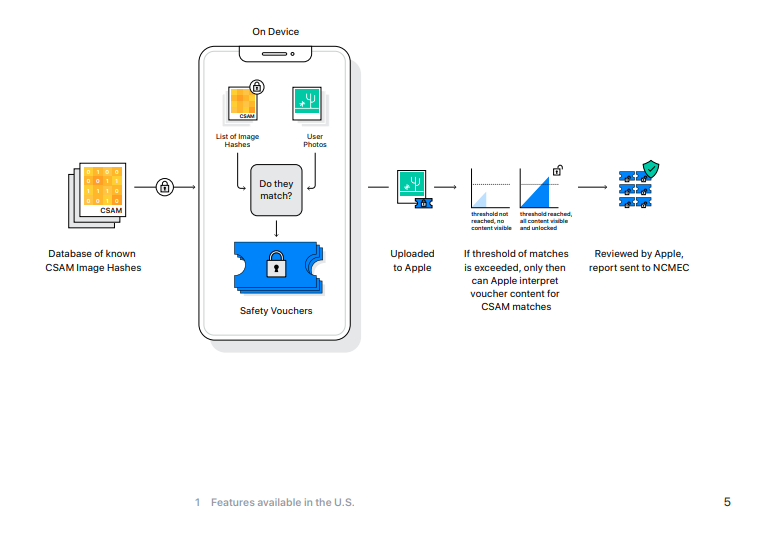

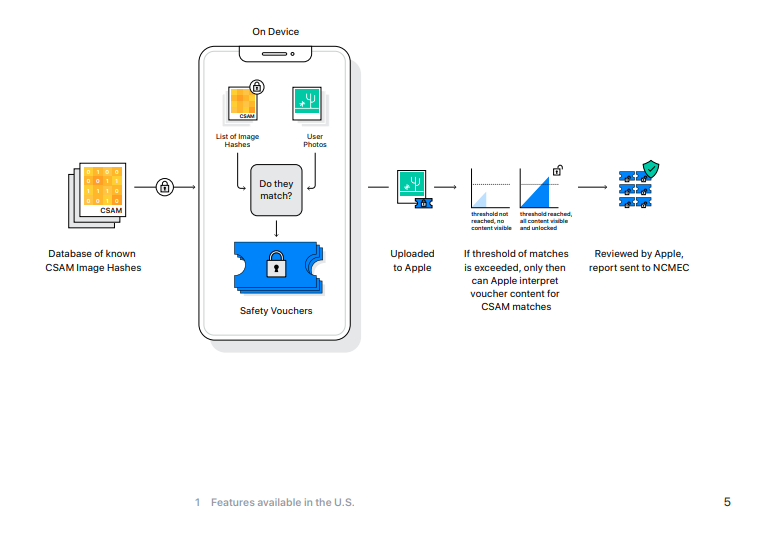

Según la Electronic Frontier Foundation, “aunque Apple tiene las claves para ver las fotos almacenadas en Fotos de iCloud, no escanea estas imágenes”, lo que cambiará con iOS 15 y si actualmente se hace una copia de seguridad de las fotos en iCloud de Apple, estas fotos serán sometidas a un hash y esos valores se compararán con los de CSAM conocidos.

Si un dispositivo iOS tiene activada la función de copia de seguridad de iCloud, este análisis comenzará primero en la máquina local. El nuevo iOS 15 incluye una versión de la base de datos de imágenes con hash del CSAM del Centro Nacional para Niños Desaparecidos y Explotados, y las imágenes no codificadas tomadas en un iPhone tendrán sus hash (un valor numérico *esperadamente * único que representa la imagen) comparados con los de la base de datos del NCMEC. En caso de que haya una coincidencia, las fotos se envían a revisores humanos en Apple. Si estos revisores pueden confirmar la coincidencia, la imagen se envía al NCMEC, a las fuerzas del orden, y la cuenta del usuario se desactiva.

Si utilizas iCloud para hacer una copia de seguridad de tus fotos, éstas se cotejarán con esta base de datos, sin que exista una causa probable o sospecha de que puedas haber cometido o estar involucrado en algún delito.

[No mires esta fotografía.

La última novedad en materia de seguridad infantil es una actualización de Siri y Search que ofrecerá orientación sobre cómo denunciar casos de CSAM, así como “intervenir” si los usuarios buscan términos relacionados con el CSAM.

La lista exacta de palabras no es pública y no sabemos si los términos reportados por los usuarios se utilizarán para entrenar el monitor de búsqueda de aprendizaje automático.

Hay muy poca información disponible sobre qué tipo de términos activarán estas advertencias y qué ocurre cuando se ignoran. En el caso de la revisión de hashtags de imágenes, un empleado de Apple determinará los resultados coincidentes, pero no sabemos qué otras medidas se toman con los resultados de las búsquedas. En la página de prensa oficial de Apple sobre estas nuevas funciones, la discusión sobre los términos de búsqueda controlados consiste en unas breves cuatro frases. También será interesante ver si esta lista crece en base a los términos reportados por los usuarios o cómo Apple decide entrenar este algoritmo.

Si no tienes nada que ocultar…

Entre estas tres nuevas características, los usuarios de Apple y aquellos que envían mensajes y fotos con ellos, están siendo sometidos al escaneo de sus mensajes encriptados, al monitoreo de sus términos de búsqueda privados, y todo esto ocurre sin ninguna sospecha o evidencia de un crimen. Una cosa es que Apple y otras grandes empresas tecnológicas escaneen los hashes de las imágenes almacenadas en sus servidores. Al fin y al cabo, estos servidores son propiedad de la empresa y no tienen por qué utilizarlos. Pero imponer estas nuevas funciones de vigilancia en los dispositivos locales ignora el hecho de que usted, el propietario del dispositivo, ha pagado cientos de dólares (o euros) por un dispositivo que está vigilando su comportamiento. No tiene mucha capacidad de elección en cuanto a los procesos que se ejecutan en una pieza de su propiedad personal. Esta “mejora” se aleja aún más del modelo de producto como servicio que ya se ha convertido en la corriente principal en el mundo del software propietario.

Con esta nueva versión de iOS, Apple está socavando la seguridad de su antes alabada plataforma de mensajería. Una aplicación de mensajería encriptada de extremo a extremo que escanea las imágenes una vez que llegan al dispositivo de destino es una peligrosa mentira que no hace nada para proteger la seguridad y la privacidad de los usuarios de Apple. El hecho de que este comportamiento pueda ser aplicado por estados nacionales que no respetan los derechos humanos es una receta para el desastre.

IOS 15 establece un peligroso estándar para el futuro del cifrado de extremo a extremo.

Proteger a los niños será el mantra que nos lleve a un mundo de mayor vigilancia y a la disolución de la privacidad personal. Sí, el CSAM es aborrecible y debería ser perseguido con todo el peso de la ley, pero la existencia del CSAM no justifica el abandono de un debate matizado en torno a la privacidad, el cifrado de datos, la violencia sexual y la vigilancia.

Matthew Green advierte de las consecuencias de estos cambios escribiendo: “Independientemente de cuáles sean los planes de Apple a largo plazo, han enviado una señal muy clara. En su (muy influyente) opinión, es seguro construir sistemas que escaneen los teléfonos de los usuarios en busca de contenido prohibido. Ese es el mensaje que están enviando a los gobiernos, a los servicios de la competencia, a China, a ti”.