Gmail, Microsoft, Meta, LinkedIn: Eles já analisam as suas mensagens - voluntariamente!

O controlo voluntário de conversação já está em vigor desde 2021, com o nome de Regulamento (UE) 2021/1232. Semelhante às obrigações de controlo no Reino Unido e nos EUA, este regulamento permite que as grandes tecnologias analisem todos os seus dados. Mas o que é que os serviços analisam com base neste regulamento, será que também analisam mensagens antigas e o que é que isto significa para a proteção de dados e a privacidade? Um mergulho profundo.

E se acha que isto não é importante para si porque não tem nada a esconder, veja a história deste pai que viu toda a sua conta Google ser apagada porque enviou uma fotografia do filho nu ao médico de família.

Agora que já tenho a vossa atenção, vejam quem está a analisar os vossos e-mails e mensagens e o que podem fazer a esse respeito!

Controlo voluntário de conversação: Regulamento (UE) 2021/1232

Há mais de três anos que a União Europeia discute o regulamento para detetar material de abuso sexual de crianças (CSAM), denominado Chat Control devido às suas imensas implicações de vigilância. E, embora os defensores da privacidade tenham conseguido eliminar a obrigação de quebrar a encriptação de ponta a ponta na atual proposta de controlo das conversas, a UE já pôs em prática uma forma voluntária de controlo das conversas que é muito utilizada pelos serviços das grandes tecnologias dos EUA: o regulamento 2021/1232.

Gmail, Facebook, Instagram, WhatsApp, Microsoft, LinkedIn, Apple - todos eles analisam os seus dados com base neste regulamento, muitas vezes com uma ferramenta desenvolvida pela Microsoft, chamada photoDNA. As Big Tech só analisam as mensagens e os e-mails recentemente recebidos, não analisam as mensagens antigas - estas já foram analisadas no passado.

A Comissão Europeia solicitou à Big Tech dados sobre as verificações para provar que estas são proporcionais. Mas a Comissão Europeia não conseguiu provar o seu ponto de vista:

Quanto à proporcionalidade do Regulamento (UE) 2021/1232, a questão é saber se o regulamento alcança o equilíbrio pretendido entre, por um lado, a realização do objetivo de interesse geral de combater eficazmente os crimes extremamente graves em causa e a necessidade de proteger os direitos fundamentais das crianças (e.dignidade, integridade, proibição de tratamentos desumanos ou degradantes, vida privada, direitos da criança, etc.) e, por outro lado, a salvaguarda dos direitos fundamentais dos utilizadores dos serviços abrangidos (por exemplo, privacidade, proteção dos dados pessoais, liberdade de expressão, recurso efetivo, etc.). Os dados disponíveis são insuficientes para dar uma resposta definitiva a esta questão. “

Em vez de provar que o regulamento é proporcional - porque a digitalização em massa de dados pessoais é uma intromissão grave na vida privada de cada cidadão e não deve ser permitida “por precaução” - a Comissão Europeia limita-se a afirmar que a digitalização de mensagens não é desproporcionada e, por conseguinte, não tem qualquer problema:

Não é possível nem seria adequado aplicar um padrão numérico ao avaliar a proporcionalidade em termos do número de crianças resgatadas, dado o impacto negativo significativo na vida e nos direitos de uma criança que é causado pelo abuso sexual. No entanto, tendo em conta o que precede, não há indicações de que a derrogação não seja proporcional. “

Esta inversão do ónus da prova foi fortemente criticada pela Netzpolitik e por Patrick Breyer, antigo deputado europeu e advogado, que qualifica a conclusão da Comissão Europeia de “absurdo jurídico”.

Mas olhemos para os dados!

As grandes tecnologias analisam milhares de milhões de conjuntos de dados

Apenas dois prestadores de serviços comunicaram à Comissão Europeia números concretos sobre a escala da análise voluntária de CSAM: A Microsoft e o LinkedIn.

-

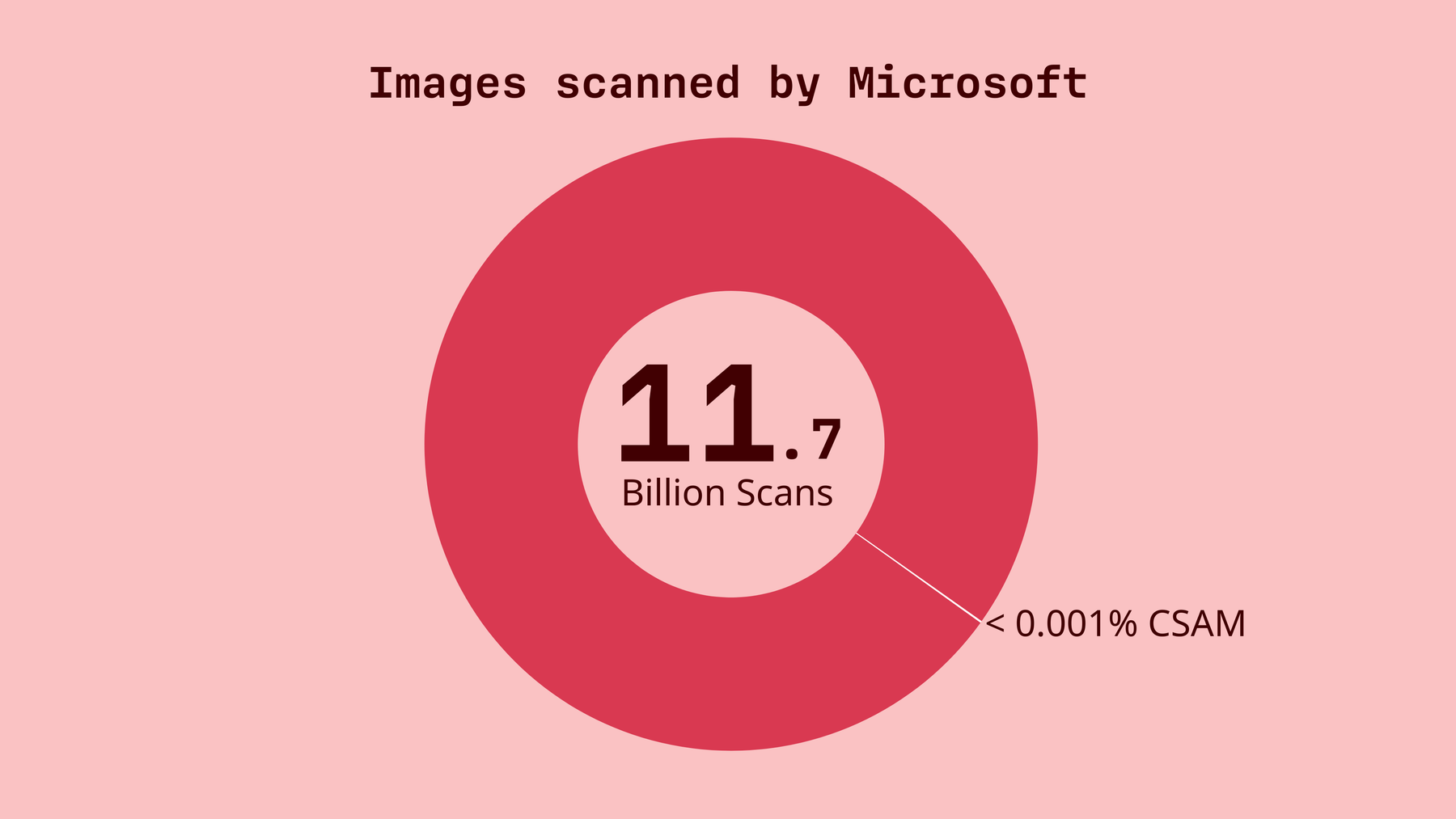

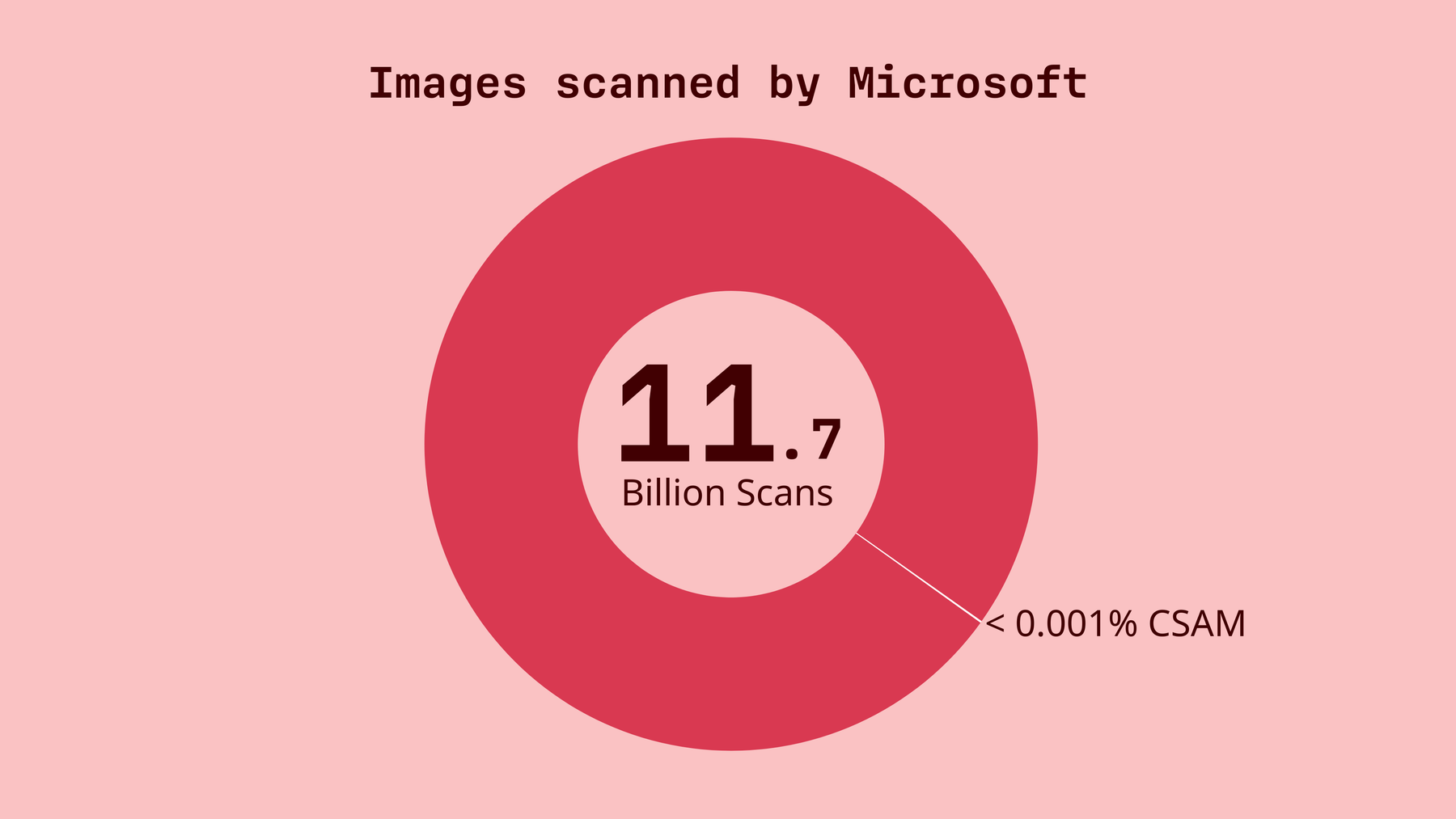

A Microsoft digitalizou mais de 11,7 mil milhões de imagens e vídeos em todo o mundo em 2023 e pouco menos de 10 mil milhões em 2024. Não forneceram números apenas para a UE.

-

Em 2023, a Microsoft sinalizou 32 000 conjuntos de dados como potencial material de abuso sexual de crianças, incluindo mais de 9 000 conjuntos de dados na UE. Este valor corresponde a 0,0002735%, ou seja, uma resposta positiva por cada 365 000 análises.

-

Em 2024, a Microsoft assinalou 26 000 conjuntos de dados como potencial material pedopornográfico, incluindo mais de 5800 conjuntos de dados na UE. Isto corresponde a 0,00027083%, ou seja, uma resposta positiva por cada 369 000 análises.

-

Os volumes do LinkedInforam muito inferiores, mas todas as análises incidiram sobre conteúdos europeus.

-

Em 2023, foram analisados mais de 24 milhões de imagens e mais de 1 milhão de vídeos, resultando em 2 imagens sinalizadas e nenhum vídeo sinalizado como potencial material de abuso sexual de crianças. Este valor corresponde a 0,00000833 %, ou seja, 1 resultado positivo por cada 12 milhões de análises.

-

Em 2024, mais de 22 milhões de imagens e mais de 2 milhões de vídeos foram analisados, resultando em 1 imagem e nenhum vídeo sinalizados como potencial material de abuso sexual de crianças. Isto corresponde a 0,00000417 %, ou seja, 1 resultado positivo por cada 24 milhões de exames.

Em ambos os casos, a análise em massa produziu apenas resultados mínimos, mas a Comissão Europeia considera a medida de controlo voluntário do Chat proporcional.

A Google não revelou quantos conteúdos foram analisados, apenas os resultados, mas, tendo em conta o facto de a Google ser um dos maiores serviços em linha, é provável que os números sejam da ordem dos milhões. Em 2023 e 2024, a Google assinalou 1.558 e 1.824 conjuntos de dados, respetivamente. Dada a dimensão da Google, os volumes de digitalização são provavelmente comparáveis aos da Microsoft, o que significa que os resultados também permanecem muito abaixo do intervalo por milhar.

O Meta com serviços como o Facebook, o Instagram e o WhatsApp destaca-se nitidamente com valores muito mais elevados. Em 2023 e 2024, o gigante tecnológico de Silicon Valley assinalou 3,6 milhões e 1,5 milhões de imagens e vídeos como potenciais CSAM na UE.

Um padrão semelhante torna-se visível quando se analisam os relatórios dos utilizadores: Na Google, 297 (2023) e 216 (2024) utilizadores denunciaram material ilegal. No Meta, 254 500 (2023) e 76 900 (2024) utilizadores comunicaram material ilegal. No relatório da Comissão, não é dada qualquer explicação para o facto de estes números apresentarem diferenças tão acentuadas.

Estes números, quando analisados de forma crítica, não provam de forma alguma que a verificação em massa das mensagens de toda a gente é proporcional. E o próximo projeto de controlo das conversas, que em breve será discutido no trílogo, poderá permitir uma análise ainda mais extensa - ainda que voluntária, mas com consequências significativas para a sua privacidade.

O bom e o mau

O aspeto positivo da atual proposta de controlo das conversas é que a verificação de mensagens de correio eletrónico e de chat continuará a ser voluntária. A proposta não obrigará os fornecedores de correio eletrónico com encriptação de ponta a ponta, como o Tuta Mail, a utilizar a encriptação. Assim, na Tuta, os seus dados permanecerão seguros. Nós da Tuta estamos aqui para lutar pelo seu direito à privacidade; quando o debate sobre o Chat Control estava no auge em 2024, até ameaçamos processar a UE por negligenciar o direito de todos à privacidade, o que agora não é mais necessário.

No entanto, o controlo voluntário das conversas não é apenas fundamentalmente mau, é errado: Sem provar que a medida é proporcional à proteção das crianças, a Comissão Europeia sacrifica a vida pessoal de todos, abrindo uma imensa intrusão na privacidade de todos por parte da Big Tech - e a Big Tech não precisa de ser questionada duas vezes.

Assim, o Gmail, a Microsoft, o LinkedIn, o Meta - todos eles analisam alegremente os seus dados - sem terem qualquer problema com isso. Isto permite-lhes não só analisar os seus dados para CSAM, mas potencialmente para qualquer outra coisa que queiram; conhecê-lo de dentro para fora , como um CEO da Google afirmou uma vez, e criar um perfil sobre si para publicar anúncios direcionados.

Mudar para a privacidade

No entanto, tem uma opção: existem serviços que oferecem soluções gratuitas e seguras de correio eletrónico, chat e redes sociais, sem qualquer rastreio ou definição de perfis.

Diga “não” às grandes tecnologias e à recolha de dados. Diz “Olá” à privacidade!