Maçãs podres: iOS 15, privacidade pessoal, e a luta em curso contra a CSAM.

“iOS 15 Em contacto. No momento.”

Com esta nova atualização do sistema operacional, parece que estamos recebendo três novas funcionalidades que, segundo a Apple, “ajudarão a proteger as crianças dos predadores que usam ferramentas de comunicação para recrutá-los e explorá-los, e limitar a propagação de Material de Abuso Sexual Infantil (CSAM)“. A primeira visa melhorar a “Segurança na comunicação de mensagens”, que acrescenta novas ferramentas de controle parental e avisos que aparecerão quando o material sexualmente explícito for enviado ou recebido. O segundo é uma funcionalidade que utilizará um algoritmo de detecção CSAM para procurar na aplicação Fotos hashes de imagem que correspondam aos hashes CSAM conhecidos. A terceira nova funcionalidade de protecção infantil introduz a “orientação” de pesquisa que fornece aos utilizadores recursos para reportar CSAM e intervirá activamente se os utilizadores procurarem um termo que esteja relacionado com CSAM. Vamos tirar um momento e descompactar os detalhes do que estas funcionalidades pretendem fazer e como o fazem.

Chega de fotos de d *ck não solicitadas.

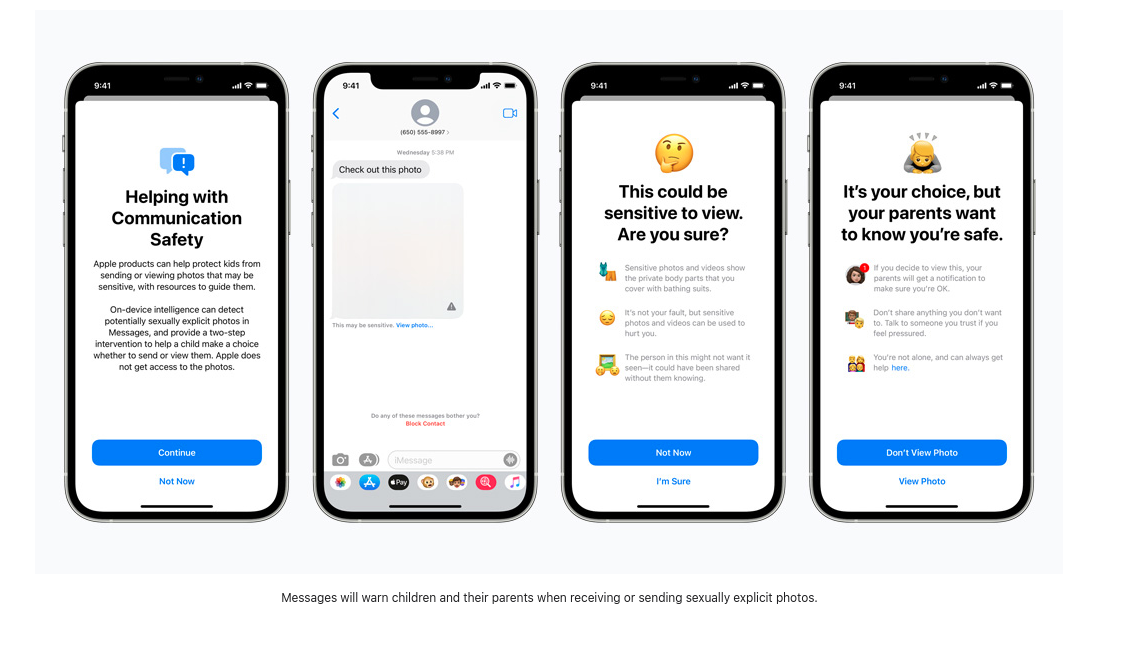

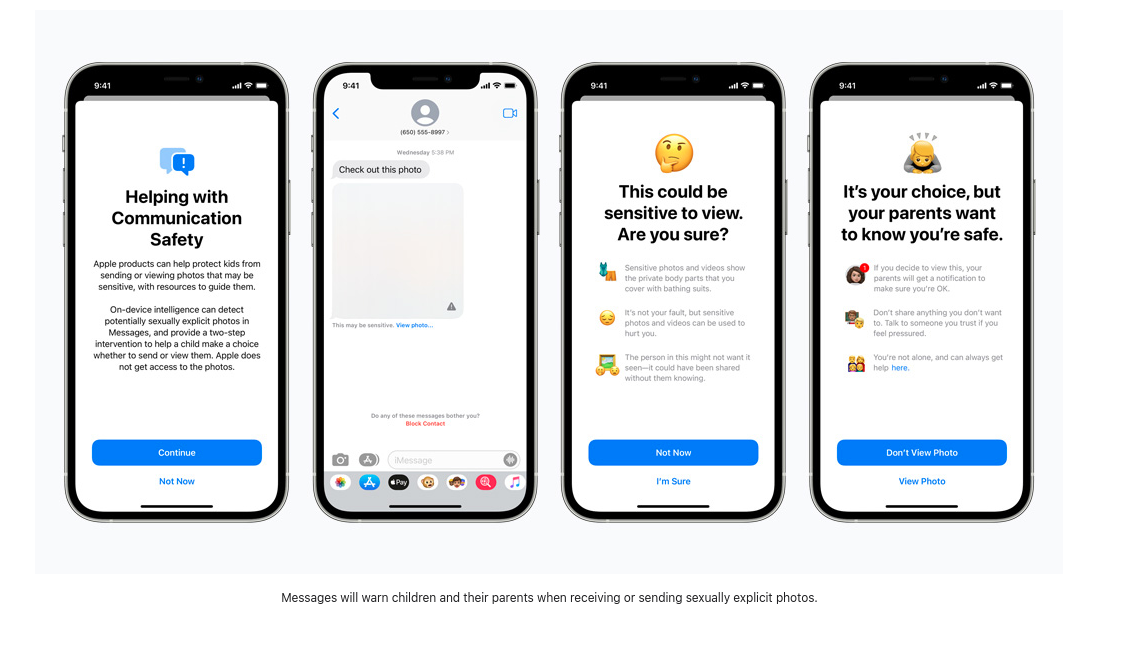

Um estudo recente da Thorn relata que “O material de abuso sexual infantil auto-gerado (SG-CSAM) é uma área em rápido crescimento do material de abuso sexual infantil (CSAM) em circulação online e a ser consumido por comunidades de abusadores”. A partilha de “nus” entre parceiros românticos muitas vezes se espalha por um grupo de pares e pode acabar online em casos de “pornografia de vingança”. A Apple vai agora começar a apresentar às crianças (ou utilizadores com estas características de segurança activadas) avisos sobre a visualização ou envio de imagens explícitas. Caso uma imagem seja visualizada ou enviada, o dispositivo dos pais receberá uma mensagem de notificação sobre a actividade.

As imagens recebidas são digitalizadas por um programa de aprendizagem no dispositivo que assinala material suspeito e “aprende” para determinar se as imagens futuras se enquadram na mesma categoria. Quem controla este algoritmo e que impacto os usuários podem ter para influenciar a forma como ele reporta imagens suspeitas permanecem não reveladas. A Apple escreve que este “recurso foi projetado para que a Apple não tenha acesso às mensagens”. Assim, com esta nova atualização, a Apple começará a triagem de mensagens criptografadas que são enviadas via iMessage a fim de alertar pais e adolescentes sobre comportamentos on-line prejudiciais.

Na superfície, isto pode não parecer perigoso, mas se esta mesma tecnologia de rastreamento fosse empregada para rastrear mensagens criptografadas para opiniões políticas dissidentes, línguas religiosas minoritárias ou discussões de orientação sexual, este novo software de monitoramento no dispositivo poderia ser facilmente alterado e abusado.

Scanning to Stop the Spread.

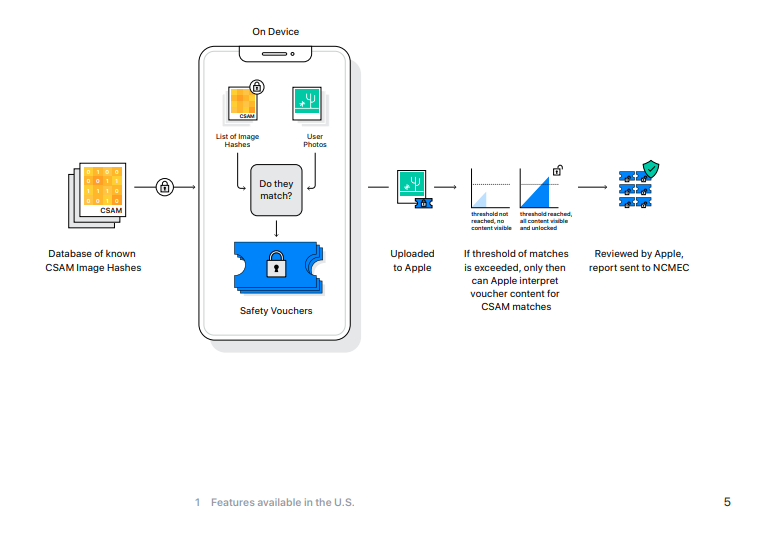

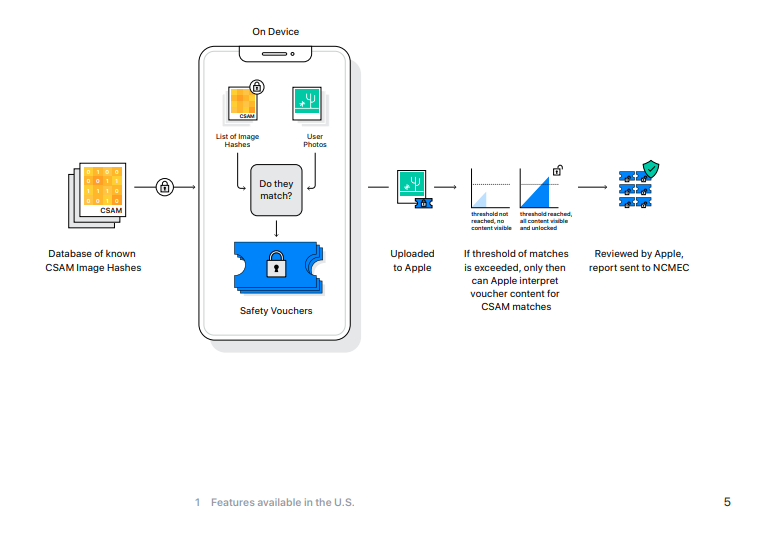

De acordo com a Electronic Frontier Foundation, “embora a Apple tenha as chaves para ver as fotos armazenadas no iCloud Photos, ela não digitaliza essas imagens”. Isso mudará com o iOS 15 e se você estiver fazendo backup das suas fotos no iCloud da Apple, essas fotos serão hashed e esses valores serão comparados com os valores do CSAM conhecido.

Se um dispositivo iOS tiver activado a funcionalidade de cópia de segurança iCloud, esta verificação começará primeiro na máquina local. O novo iOS 15 inclui uma versão do National Center for Missing and Exploited Children’s CSAM hashed image database, e as imagens não encriptadas tiradas num iPhone terão os seus hashes (um valor numérico único *hopefully * que representa a imagem) comparado com os da base de dados NCMEC. No caso de ocorrer uma correspondência, as fotos são enviadas para revisores humanos na Apple. Se estes revisores puderem confirmar a correspondência, então a imagem é enviada para NCMEC, as autoridades policiais e a conta do usuário será então desativada.

Se você estiver usando o iCloud para fazer backup de suas fotos, suas fotos serão digitalizadas contra esta base de dados, sem causa provável ou suspeita de que você possa ter cometido ou estado envolvido em qualquer crime.

[Não] Veja esta Fotografia.

A nova função final de segurança das crianças é uma atualização da Siri e Search que oferecerá orientação sobre como relatar casos de CSAM, bem como “intervir” se os usuários estiverem procurando por termos relacionados à CSAM.

A lista de palavras exacta não é pública e não sabemos se os termos reportados pelos utilizadores serão utilizados para treinar o monitor de pesquisa de aprendizagem da máquina.

Há muito pouca informação disponível sobre que tipo de termos desencadearão estes avisos e o que acontece quando eles são ignorados. No caso de revisão de hashing de imagem, um funcionário da Apple determinará os resultados correspondentes, mas não sabemos que outras medidas são tomadas com os resultados da pesquisa. Ao visualizar a página de imprensa oficial da Apple para estas novas funcionalidades, a discussão dos termos de pesquisa monitorizada consiste em quatro breves frases. Também será interessante ver se esta lista cresce com base nos termos reportados pelo usuário ou como a Apple opta por treinar este algoritmo.

Se você não tem nada a esconder…

Entre estas três novas funcionalidades, os utilizadores Apple e aqueles que enviam mensagens e imagens com eles, estão a ser sujeitos à digitalização das suas mensagens encriptadas, monitorização dos seus termos de pesquisa privados, e tudo isto sem qualquer suspeita ou prova de crime. Uma coisa é a Apple e outras empresas Big Tech digitalizarem os hashes das imagens armazenadas nos seus servidores. Afinal, estes servidores são propriedade da empresa e você não precisa usá-los. Mas empurrar estes novos recursos de vigilância para dispositivos locais ignora o fato de que você, o proprietário do dispositivo, pagou centenas de dólares (ou Euros) por um dispositivo que está monitorando seu comportamento. Você não tem muita escolha em quais processos estão rodando uma parte de sua propriedade pessoal. Esta “melhoria” se desvia ainda mais para o modelo produto como serviço que já se tornou mainstream no mundo do software proprietário.

Com esta nova versão do iOS, a Apple está a minar a segurança da sua plataforma de mensagens, outrora elogiada. Um aplicativo de mensagens criptografadas de ponta a ponta que escaneia as imagens quando elas chegam ao dispositivo de destino é uma mentira perigosa que não faz nada para proteger a segurança e a privacidade dos usuários Apple. Como este comportamento pode ser aplicado por estados nacionais que não respeitam os direitos humanos é uma receita para o desastre.

O IOS 15 estabelece um padrão perigoso para o futuro da criptografia de ponta a ponta.

Proteger as crianças será o mantra que nos levará a um mundo de maior vigilância e à dissolução da privacidade pessoal. Sim, a CSAM é abominável e deve ser processada em toda a extensão da lei, mas a existência da CSAM não garante o abandono de uma discussão matizada sobre privacidade, criptografia de dados, violência sexual e vigilância.

Matthew Green adverte sobre as consequências destas mudanças escrevendo: “Independentemente dos planos a longo prazo da Apple, eles enviaram um sinal muito claro. Na sua opinião (muito influente), é seguro construir sistemas que façam varredura nos telefones dos usuários em busca de conteúdo proibido. Essa é a mensagem que eles estão enviando aos governos, aos serviços concorrentes, à China, a você”.