Гнилые яблоки: iOS 15, личная конфиденциальность и продолжающаяся борьба с CSAM.

“iOS 15 На связи. В моменте”.

В новом обновлении операционной системы, похоже, мы получим три новые функции, которые, по словам Apple, “помогут защитить детей от хищников, использующих средства коммуникации для вербовки и эксплуатации, а также ограничить распространение материалов сексуального насилия над детьми (CSAM)“. Первая функция направлена на улучшение “безопасности общения в Сообщениях”, которая добавляет новые инструменты родительского контроля и предупреждения, которые будут появляться при отправке или получении материалов сексуального характера. Вторая функция использует алгоритм обнаружения CSAM для сканирования приложения “Фото” на наличие хэшей изображений, которые соответствуют известным хэшам CSAM. Третья новая функция защиты детей представляет собой поисковое “руководство”, которое предоставляет пользователям ресурсы для сообщения о CSAM и будет активно вмешиваться, если пользователи будут искать термины, связанные с CSAM. Давайте отвлечемся и подробно разберем, что и как делают эти функции.

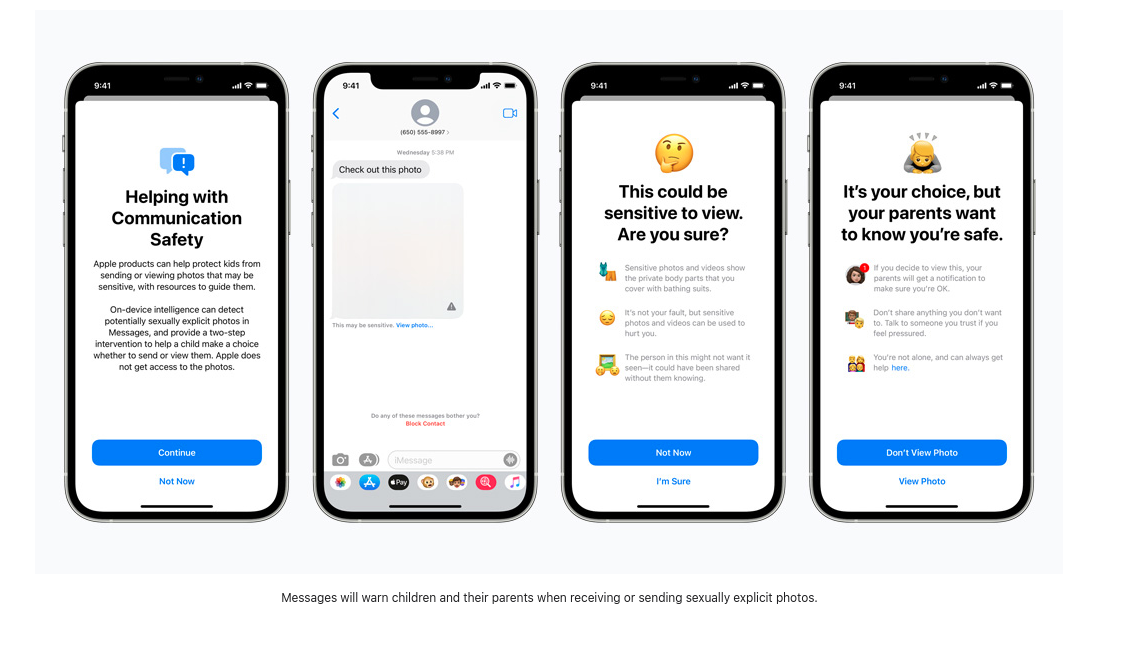

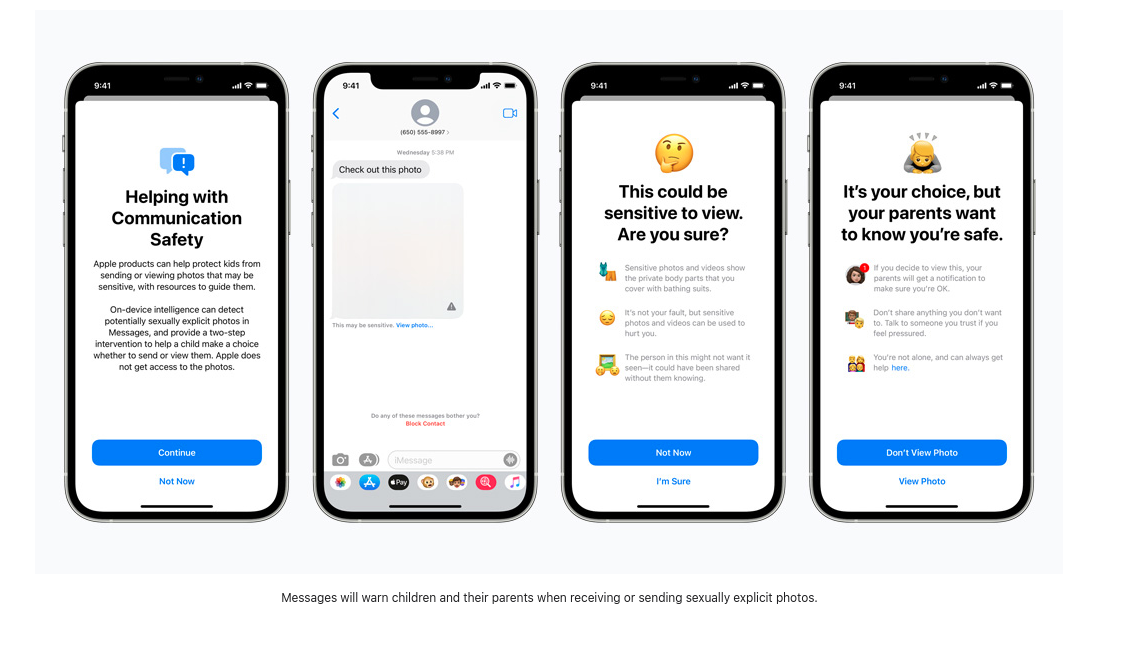

Больше никаких непрошеных фотографий члена.

Недавнее исследование Thorn сообщает, что “Самостоятельно созданные материалы о сексуальном насилии над детьми (SG-CSAM) - это быстро растущая область материалов о сексуальном насилии над детьми (CSAM), циркулирующих в сети и потребляемых сообществами насильников”. Новая “Расширенная защита детей” от Apple направлена на замедление роста этой практики. Обмен “обнаженными” фотографиями между романтическими партнерами часто распространяется в группе сверстников и может попасть в Интернет в случаях “порно мести”. Теперь Apple начнет показывать детям (или пользователям с включенными функциями безопасности) предупреждения о просмотре или отправке откровенных изображений. В случае просмотра или отправки изображения на устройство родителей будет отправлено уведомление об этом действии.

Входящие изображения проверяются программой машинного обучения на устройстве, которая отмечает подозрительные материалы и “учится” определять, попадают ли будущие изображения в ту же категорию. Кто контролирует этот алгоритм и какое влияние пользователи могут оказать на то, как он сообщает о подозрительных изображениях, пока не раскрывается. Apple пишет, что эта “функция разработана таким образом, что Apple не получает доступа к сообщениям”. Таким образом, с новым обновлением Apple начнет проверять зашифрованные сообщения, отправленные через iMessage, чтобы предупредить родителей и подростков о вредном поведении в Интернете.

На первый взгляд это может показаться неопасным, но если бы эта же технология сканирования использовалась для проверки зашифрованных сообщений на наличие инакомыслия в политике, религиозных меньшинств или обсуждений сексуальной ориентации, новое программное обеспечение для мониторинга на устройстве могло бы быть легко изменено и использовано не по назначению.

Сканирование, чтобы остановить распространение.

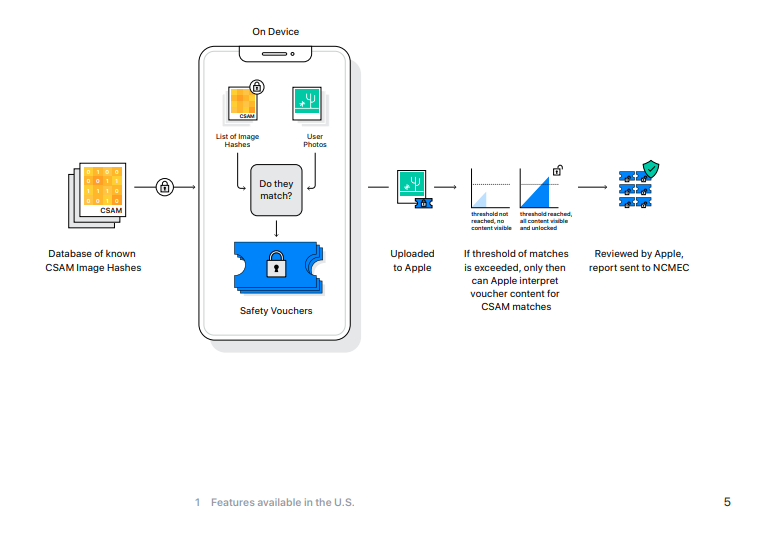

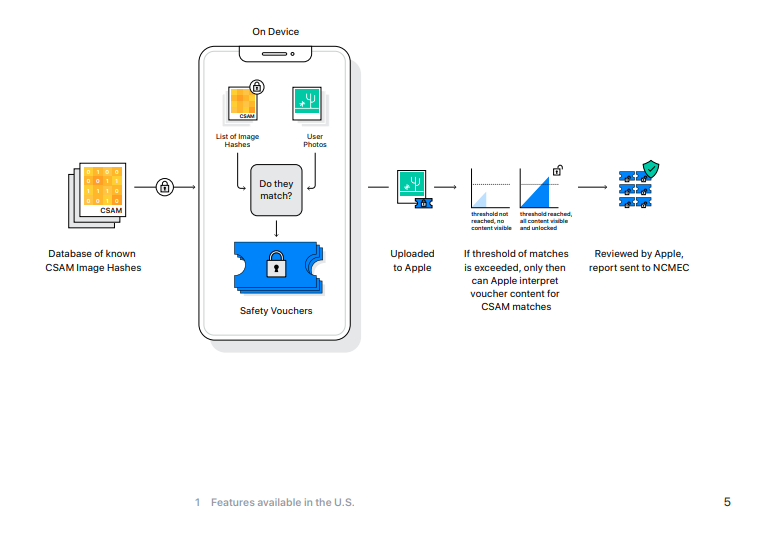

Согласно Electronic Frontier Foundation, “хотя Apple имеет ключи для просмотра фотографий, хранящихся в iCloud Photos, она не сканирует эти изображения”. Это изменится с выходом iOS 15, и если вы в настоящее время сохраняете свои фотографии в iCloud от Apple, эти фотографии будут хэшированы, и эти значения будут сравниваться с известными CSAM.

Если на устройстве iOS включена функция резервного копирования в iCloud, сканирование сначала начнется на локальной машине. Новая iOS 15 включает в себя версию базы данных хэшированных изображений CSAM Национального центра по пропавшим и эксплуатируемым детям, и незашифрованные изображения, сделанные на iPhone, будут сравниваться с хэшами (*надеемся* уникальное числовое значение, представляющее изображение) базы данных NCMEC. В случае совпадения фотографии отправляются на проверку специалистам Apple. Если эти эксперты подтверждают совпадение, то изображение отправляется в NCMEC, правоохранительные органы, а аккаунт пользователя деактивируется.

Если вы используете iCloud для резервного копирования своих фотографий, ваши фотографии будут проверены по этой базе данных без достаточных оснований или подозрений, что вы могли совершить или быть вовлечены в какое-либо преступление.

[Не смотрите на эту фотографию.

Последняя новая функция безопасности детей - это обновление Siri и Search, которое предложит рекомендации о том, как сообщать о случаях CSAM, а также “вмешиваться”, если пользователи ищут термины, связанные с CSAM.

Точный список слов не обнародован, и мы не знаем, будут ли термины, сообщаемые пользователями, использоваться для обучения монитора поиска на основе машинного обучения.

Имеется очень мало информации о том, какие термины будут вызывать эти предупреждения и что произойдет, если их проигнорировать. В случае проверки хэширования изображений сотрудник Apple будет определять совпадающие результаты, но мы не знаем, какие дальнейшие меры принимаются с результатами поиска. При просмотре официальной пресс-страницы Apple, посвященной этим новым функциям, обсуждение контролируемых поисковых запросов состоит из коротких четырех предложений. Также будет интересно посмотреть, будет ли этот список расширяться на основе терминов, сообщаемых пользователями, или как Apple решит обучить этот алгоритм.

Если вам нечего скрывать…

Благодаря этим трем новым функциям пользователи Apple и те, кто отправляет с ними сообщения и фотографии, подвергаются сканированию своих зашифрованных сообщений, мониторингу своих личных поисковых запросов, и все это происходит без каких-либо подозрений или доказательств преступления. Одно дело, когда Apple и другие крупные технологические компании сканируют хэши изображений, хранящихся на их серверах. В конце концов, эти серверы являются собственностью компании, и вы не обязаны ими пользоваться. Но при внедрении этих новых функций наблюдения на локальные устройства игнорируется тот факт, что вы, владелец устройства, заплатили сотни долларов (или евро) за устройство, которое следит за вашим поведением. У вас нет особого выбора в том, какие процессы управляют частью вашей личной собственности. Это “улучшение” еще больше приближается к модели “продукт как услуга”, которая уже стала основной в мире проприетарного программного обеспечения.

С этой новой версией iOS Apple подрывает безопасность своей некогда хваленой платформы для обмена сообщениями. Приложение для обмена сообщениями со сквозным шифрованием, которое сканирует изображения, как только они попадают на устройство назначения, - это опасная ложь, которая ничего не делает для защиты безопасности и конфиденциальности пользователей Apple. То, как такое поведение может быть применено национальными государствами, не соблюдающими права человека, - это рецепт катастрофы.

IOS 15 устанавливает опасный стандарт для будущего сквозного шифрования.

Защита детей станет мантрой, которая приведет нас в мир усиленного наблюдения и разрушения частной жизни. Да, CSAM отвратительна и должна преследоваться по всей строгости закона, но существование CSAM не является основанием для отказа от обсуждения нюансов, связанных с частной жизнью, шифрованием данных, сексуальным насилием и слежкой.

Мэтью Грин предупреждает о последствиях этих изменений: “Независимо от того, каковы долгосрочные планы Apple, они послали очень четкий сигнал. По их (очень влиятельному) мнению, безопасно создавать системы, сканирующие телефоны пользователей на предмет запрещенного контента. Это сигнал, который они посылают правительствам, конкурирующим службам, Китаю, вам”.